AEA Cheatsheet

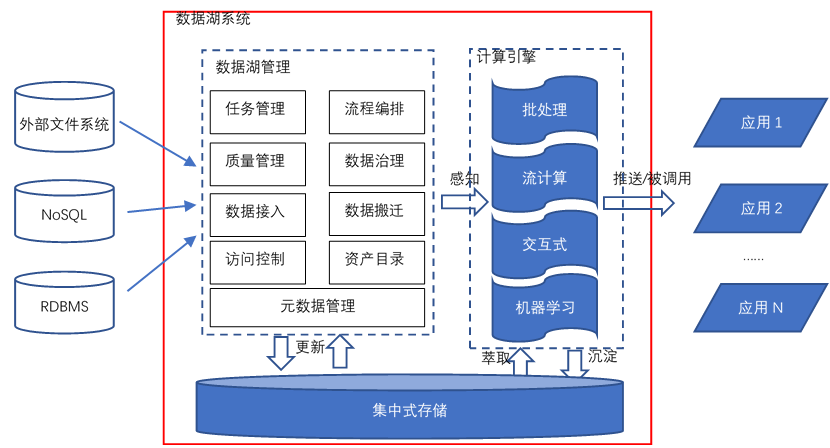

AEA CheatsheetChapter 1. Miscellenous1.1 Cookie & Session1.2 Java Spring Bean 实例池1.3 数据库连接设置Chapter 2. 异步通信:Message Queue2.1 同步通信 versus 异步通信2.2 Kafuka2.2.1 Kafka 的高性能2.2.2 Kafka 的高可扩展性2.2.3 Kafka 的高可用性2.2.4 Kafka 的持久化 & 过期策略2.2.5 Kafka Consumer Group2.2.6 ZooKeeper & KRaft2.2.7 Kafka Serializers & Deserializers2.2.8 实践:如何使用 Kafka?Chapter 3. Web Socket3.1 Definitions3.2 Coding WebSocket3.3 WebSocket Encoder & Decoder3.4 STOMP over WebSocketChapter 4. SQL 数据库进阶:事务4.1 Definitions of Transaction4.2 Problems of Transaction for Database I: Isolation4.2.1 Conflicts4.2.2 Isolation Level4.2.3 Implementations of Isolation in DB I: Locks4.2.4 Implementations of Isolation in DB II: MVCC4.2.5 Implementations of Isolation in DB III: Scheduling4.2.6 补充:Design Pattern of Locks4.3 Problems of Transaction for Database II: Atomicity & Consistency4.3.1 Rollback & Faults Recovery4.3.2 Implementation of Atomicity & Consistency in DB: LogsA. 事务故障 / 系统崩溃补充:数据库日志的实现方式4.4 Problems of Distributed Transaction in Different Database (Atomic)4.5 Transaction in SpringChapter 5. SQL 数据库进阶:优化5.1 索引5.1.1 Overview5.1.2 Implementations5.1.3 MySQL 何时会使用索引5.1.4 列索引优化前缀索引聚簇索引全文索引稀疏索引 (Sparse Index)空间索引 (Spatial Index)多列索引(复合索引)内存索引Hash 索引降序索引5.2 主键优化5.3 外键优化5.4 数据库结构优化5.4.1 数据大小5.4.2 MySQL 数据类型5.5 数据库多表优化5.5.1 MySQL 如何管理 Open/Close Tables5.5.2 数据库数量限制调优数据库/数据库表的数量数据库表的大小数据库表的列数和行的大小5.6 InnoDB 表优化5.6.1 InnoDB 存储效率优化5.6.2 InnoDB 事务优化5.6.3 InnoDB 载入大量数据时优化5.6.4 InnoDB 查询优化5.6.5 InnoDB Disk I/O 优化5.6.6 InnoDB DDL 操作优化5.7 MEMORY 表优化5.8 Buffering and CachingChapter 6. 数据库备份与恢复6.1 备份和恢复的类型6.2 实践6.3 备份和恢复的策略Chapter 7. 数据库分区7.1 Types of Partitioning7.1.1 RANGE Partitioning7.1.2 LISTING Partitioning7.1.3 HASH Paritioning7.1.4 KEY Partitioning7.2 Subpartitioning7.3 How About NULL in Partitions?7.4 Partitioning Management7.5 分区与表 的交换Chapter 8. NoSQL8.1 Why we need it?8.2 MongoDB8.2.1 DefinitionsDocumentCollectionDatabase8.2.2 Indexing8.2.3 ShardingReasonsShard & Chunks8.3 Neo4J8.3.1 Definitions8.3.2 Data Model8.3.3 Storage Mechanism8.4 Log-Structured Database日志结构数据库中的读放大和写放大8.5 Vector Database8.5.1 Basic Concepts8.5.2 ANN Search Algorithms8.5.3 Similarity Measurement8.6 Timeseries DatabaseChapter 9. Concurrency Control9.1 Thread in Java9.1.1 Usage9.1.2 Synchronized Methods9.1.3 Reentrant Synchronization9.1.4 Atomic Access & Keyword volatile9.1.5 Dead Lock, Starvation, Live Lock9.1.7 Immutable Objects9.1.8 High Level Concurrency ObjectsLock ObjectsExecutorsConcurrent CollectionsAtomic VariablesVirtual ThreadsChapter 10. Memory Caching10.1 Background10.2 Memcached10.3 Distributed KV Store10.4 Redis10.4.1 为何需要?10.4.2 缓存读写策略10.4.3 缓存 Evict 策略10.4.4 缓存击穿 & 缓存雪崩Chapter 11. Full-text Searching11.1 Lucene11.1.1 Concepts11.1.2 Metrics11.1.3 Core Classes11.1.4 Searching Procedure11.1.5 Java Example11.1.6 Field 域类型11.1.7 维护索引11.1.8 Tokenism & Analyzers11.1.9 Advanced Search11.1.10 Similarity SortChapter 12. RESTful Web Service12.1 SOAP & WSDL12.2 RESTful Web Service12.2.1 Definitions12.2.2 Principles of REST12.2.3 Design Standards of RESTful API12.3 ConclusionChapter 13. Revisit: Microservices13.1 注册中心 & 微服务网关13.2 微服务雪崩13.3 微服务保护Chapter 14. HTAP14.1 Business Logic14.2 SolutionsChapter 15. Data Lake15.1 Concepts15.2 Evolution History15.3 Data Source 从哪来?Chapter 16. Cluster16.1 Why Cluster?16.2 Load Balance16.3 MySQL 集群和 Nginx Load Balance Policies16.4 Proxy & Reverse ProxyChapter 17. Cloud Computing & Edge Computing17.1 MapReduce17.2 Distributed File System17.3 Google BigTable: KV Store 鼻祖17.4 Summary: Components of Cloud OS17.5 Definitions of Edge ComputingChapter 18. GraphQL18.1 为什么需要 GraphQL?18.2 GraphQL Grammar18.3 GraphQL with Spring BootChapter 19. HadoopChapter 20. Spark20.1 Overview20.2 Spark Components20.3 Spark RDD (Resilient Distributed Dataset)20.3.1 Definitions20.3.2 RDD Operations20.3.3 RDD Partition20.3.4 RDD Dependencies20.4 Spark's Usage20.5 流式处理 & 批处理 & 流批一体架构Chapter 21. StormChapter 22. HDFS22.1 Definitions22.1.1 Design Assumptions: environments22.1.2 ArchitectureComparison between Improved NFS & HDFSInteraction ModelInterface22.2 Operations22.2.1 Reading a file in GFS22.2.2 Writing a file in GFS22.3 Features22.3.1 Safe Mode22.3.2 Rack Awareness22.3.3 Robustness & Fault ToleranceChapter 23. HBaseChapter 24. Hive24.1 Definitions & Meanings24.2 特性 & 与关系型数据库比较A. Scalability and PerformanceB. Data ModelC. Concurrency and Transaction (OLTP) SupportD. Data Processing TypeE. Data Storage24.3 再谈数据湖、数据仓库Chapter 25. Flink25.1 Scene25.2 The States of Flink25.3 Watermarks of Flink25.4 The Architecture of FlinkChapter 26. AI26.1 Full-Connected NN26.2 分类神经网络构建26.3 CNN26.4 TLP26.5 RNN & LSTM26.6 ChatGPT & Transformer

Chapter 1. Miscellenous

1.1 Cookie & Session

核心问题是什么呢? Http协议是一种无状态的协议!也就是说,每次请求都是独立的,服务器并不知道你是谁,你上次请求的信息是什么。

所以,怎么解决这个问题呢?

Cookie:客户端浏览器用来保存用户信息的一种机制;当我们通过浏览器进行网页访问的时候,服务器会将一些数据以cookie的形式保存在客户端浏览器上,当下次客户端浏览器再次访问该网站时,会将 cookie 数据发送给服务器,服务器通过 cookie 数据来辨别用户身份。(cookie 存的是 kv 键值对)

Session:表示一个会话,是属于服务器端的一种容器对象;

默认情况下,针对每个浏览器的请求,server 都会创建一个 session 对象,生成一个

sessionId,用于标识该 session 对象,同时将sessionId以 cookie 的形式发送给客户端浏览器;客户端浏览器再次访问该网站时,会将 cookie 数据发送给服务器,服务器通过 cookie 数据来辨别用户身份,从而找到对应的 session 对象,如果找不到,就会创建一个新的 session 对象。

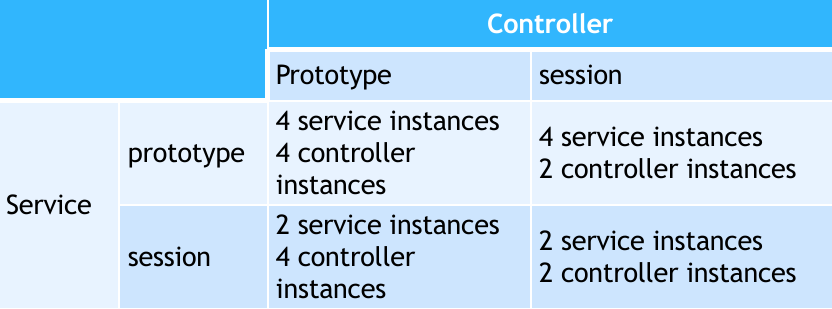

1.2 Java Spring Bean 实例池

"对象池"(Object Pool)是一种设计模式,它是一种用于管理和重用对象实例的机制,以提高性能和资源利用率的方式。对象池通常用于减少创建和销毁对象的开销,特别是在对象的创建成本较高或频繁创建和销毁对象可能导致性能下降的情况下。 在 Java 中,对象池通常是一个集合,用于存储和管理多个对象实例。当需要使用对象时,可以从对象池中获取一个可用的对象,而不是每次都创建新的对象。一旦使用完成,可以将对象返回到对象池中,以便稍后重用,而不是立即销毁它。

实例池的数量一定有上限的,不可能运行每一个用户上来都能创建一个对象,否则请求频率较高的时候内存直接爆炸。假设我们只能创建两个对象,这样内存就不会爆炸了。那是怎么服务于多个用户呢?

假设 A 用户来了,我们创建一个实例 A',然后 B 来了创建一个 B',现在实例池满了;

C 来了之后,根据 LRU Algorithm,把 A' 从内存里面换出落盘,然后创建一个 C 的实例;

这个过程就称为 Java 实例的 swap in 和 swap out;使用类似页表换入换出的方式,实现服务超过当前实例数量的 clients;

因此,系统尽量要无状态的,减少或集中有状态的服务(否则需要创建多个 Bean 实例)。

两次调用不会相互影响(不会改变系统状态),或者说幂等的。

比如说我们要统计一个网站在线用户的数量,这样所有用户公用的一个域就是count:反应用户数量,这样就是无状态的(这个状态是公用的,不是每个用户都有一个);

如果是每个人来了以后,每个人的对象都不一样,那么就是有状态的。但是有状态的就需要针对每个用户单独存储,占用空间,所以尽可能的少或者避免。

在 Java Spring 中,管理 Bean 实例创建策略的注解是

@Scope(Bean 作用域),它可以管理 Bean 实例的生存周期以及可见性:

Singleton(单例): 这是 Spring 默认的作用域。在单例作用域下,Spring IoC Container 对一个类型只创建一个 bean 实例,并在应用程序的整个生命周期内重用该实例。这意味着每次请求该 bean 时,都会返回相同的实例;

Prototype(原型): 在原型作用域下,每次调用(invoke)涉及该 bean 的类型时,Spring IoC Container 都会创建一个新的 bean 实例。这意味着每次请求都会返回一个不同的实例;

Request(请求): 这个作用域适用于 Web 应用程序,每次 HTTP 请求(不管是否来自同个客户端 / 会话)都会创建一个新的 bean 实例,每个请求之间的实例不共享(位于

AppContext);Session(会话): 类似于请求作用域,但在 HTTP 会话的整个生命周期内创建和维护一个 bean 实例。不同用户的会话之间的实例不共享(位于

AppContext);Application(应用级别):在

ServletContext的整个生命周期内创建和维护一个 bean 实例(位于AppContext);WebSocket:在

WebSocket的整个声明周期内创建和维护一个 bean 实例(位于AppContext);Custom(自定义): 您还可以定义自定义的作用域,以满足特定需求。要使用自定义作用域,您需要实现 Spring 的

org.springframework.beans.factory.config.Scope接口,并将其配置到Spring容器中。

1.3 数据库连接设置

连接池(Connection Pool)是一种用于管理和重用数据库连接、网络连接或其他资源连接的技术,旨在提高应用程序性能和资源利用率。连接池通过维护一组已创建的连接实例,并在需要时分配这些连接,以减少创建和销毁连接的开销。

这里的连接池本质是一个线程池,里面是一大堆线程。

以下是连接池的工作原理和好处:

工作原理:

初始化连接池: 在应用程序启动时,连接池会初始化一定数量的连接实例,这些连接可以立即使用。

连接分配: 当应用程序需要使用连接时,它向连接池请求一个连接。连接池会检查是否有可用的连接实例,如果有,则分配一个给应用程序。

连接使用: 应用程序使用连接执行数据库查询、网络通信或其他操作。

连接释放: 当应用程序完成连接的使用时,它将连接释放回连接池,而不是立即关闭连接。连接池会重新标记这个连接为可用状态。

假如要支持10万用户,需要在连接池里面配置多少数据库连接?

连接池的建议计算公式为:

理论依据:

一般情况下处理器存在超线程技术,一个 Core 上可以并行运行两个线程;

在 I/O 操作过程中 CPU 一般会出现空闲状态,因此加上能够同时进行 I/O 操作的有效磁盘数;

超出建议的连接数后,过多的连接数反而会导致很多无意义的 context switch,提升了 switch overhead,降低 CPU 资源利用率;

因此我们可以说,数据库连接数只与机器资源有关,与外部的连接情况无关。

Chapter 2. 异步通信:Message Queue

2.1 同步通信 versus 异步通信

同步通信的缺陷:

代码通常是紧耦合的,可扩展性差,并且多与软件 / 平台 / 语言相关;

当模块内部需要相互交流时,要维护的接口 API 数量会爆炸式上升;

性能堪忧。相较于相同项目实现的单体架构,同步调用方式会多出网络等待时间,以及阻塞时延;

没有请求消息 buffer,当接口忙碌时会出现错误(然后数据丢失);

通信不是 replayable 的,过于依赖请求响应模型(好处:易于编程,坏处:不可靠);

异步通信的优势:

模块间进一步解耦(发布者和订阅者间无需知道相互之间的信息,data-driven);

可拓展性强(scalable),添加实例无需更改代码;

异步性能有明显提升;

故障隔离(最终一致性保证),确保消息能正确发送 或者 出错时及时按策略处理(可靠性);

缓存消息,实现流量削峰填谷;

系统对等性(A message system is a P2P facility),所有端都可以收发消息,降低维护 API 数量;

异步通信缺点:无论是消息还是异常,都通过异步通信,并且通信实现编码比较麻烦。

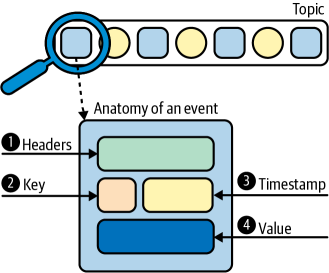

2.2 Kafuka

一个开源的分布式事件流处理中间件,以发布订阅模式进行事件处理。

Kafuka 基于日志(Log)管理消息。

这里的 “日志” 是一种仅追加(append-only)的数据结构,常用于捕获有序事件序列。

仅追加的好处是顺序写,充分利用磁盘特性,提升写的性能(Logged-Structure Merge Tree 就是利用这种特性的键值存储系统);

现在将 Kafuka 想象成一种消息队列,然后消费者利用记录的 offset 读取队列中的消息,能消费多少是多少。

2.2.1 Kafka 的高性能

那么 Kafuka 如何应对并发量更高的场景?

为了提升消息队列的吞吐量,可以将队列分类为多个队列,每个队列对应一类消息。“一类消息” 就被称为一个 topic;

生产者按 topic 向对应队列投递消息,消费者则针对性地按 topic 订阅,大大减小一个队列的压力;

但是如果这样做还不够呢?

Kafuka 将每个 topic 拆成多个 partition,多个消费同一个 topic 的消费者就可以消费不同的 partition,继续提升队列吞吐量;但是不同 partition 不保证消费消息的先后顺序(原理:利用 hash 随机拿到 topic 中的 partition 下标,负载均衡地投递和消费),但每个 partition 内是有序的;

其中,一般可以对单个消息指定 key,key 可以确保相同的 key 被放到同一个 partition 中,确保必要的数据是有序的;

详细消息体组成如下:

2.2.2 Kafka 的高可扩展性

单个机器的性能总归是有上限的,我们需要提供可扩展性(scale 到其他机器上)。

Kafuka 通过将同个 topic 中的不同 partition 分配到不同的服务节点上。不同 MQ 服务节点位于不同物理机器上,这些节点被称为 broker,多个 brokers 组成了 Kafuka cluster;

2.2.3 Kafka 的高可用性

我们解释了 Kafuka 实现应对高 QPS 情况、高可扩展性的要求,不过还没有保证高可用性。

设想一种情况,如果 Kafuka cluster 的某个 broker 挂掉了,如何保证消息不会丢失?

和大多数解决可用性的分布式系统一样,直接采用主从的 replicas 副本,主称 leader,从称 follower;leader 同时承担生产者写和消费者读的请求,follower 仅同步 leader 的消息作为备份,并且 leader 和 follower 保证异地亲和性(不在同一 broker 上确保集群容灾);

这样当一个 leader 挂掉后,从同一个 partition 的 followers 中重新选举出 leader 服务,然后在之后的一段时间内补充 replicas 数量;

2.2.4 Kafka 的持久化 & 过期策略

到目前为止,数据全部位于内存。但是需要考虑最坏情况:所有 broker 全部挂掉,这样难道数据就丢失了吗?

所以为了保证高可用性和数据安全,还需要将数据持久化到磁盘中。问题是磁盘的容量有限,持续写盘总有一天会爆满,因此我们需要指定消息的保留策略(retention policy)。常见的保留策略可以是:磁盘大小超过一定比例、消息放置超过一定时间。

2.2.5 Kafka Consumer Group

目前还有个问题,现在读消息队列的方式还是通过消息队列中的 offset 方式来读,但是如果多个消费者想访问一个 partition,那么它们将不得不共用一个 offset,首先是降低并发性能,其次是不灵活,没法满足不同的消息消费需求。

所以 Kafuka 的 partition 引入了消费者组(consumer group)的概念,让同一个消费者组内维护一套针对各个 partition 的 offset,实现更加灵活的消息订阅;

2.2.6 ZooKeeper & KRaft

在分布式系统中,有很多状态需要维护,比如说,之前我们提到多个 brokers 有几个挂了、哪些 partition 需要重新选举 leader、具体怎么选举,消费组的 offset 给谁维护,等等。这些状态一般可以用分布式协调组件完成。其中 Apache ZooKeeper 就是一种选择。

但是 ZooKeeper 的开销相当大,在一般小规模的分布式应用上很不划算,因此人们开发出轻量级的协调算法 KRaft,现已广泛应用在多种分布式系统中。

2.2.7 Kafka Serializers & Deserializers

和 RabbitMQ 一样,我们可以自定义序列化方式:

xxxxxxxxxxspring kafka producer bootstrap-serverslocalhost9092 key-serializerorg.apache.kafka.common.serialization.StringSerializer value-serializerorg.springframework.kafka.support.serializer.JsonSerializer consumer bootstrap-serverslocalhost9092 auto-offset-resetearliest properties spring json trusted packages'*' key-deserializerorg.apache.kafka.common.serialization.StringDeserializer # 注:这里更常用的是 org.springframework.kafka.support.serializer.JsonDeserializer # 这里为了展示选择的多元性选择了 ByteArray 的解码器,意味着 Listener 端需要以 ByteArray 接收 value-deserializerorg.apache.kafka.common.serialization.ByteArrayDeserializer2.2.8 实践:如何使用 Kafka?

先介绍 Spring + Gradle 引入:

xxxxxxxxxxdependencies { implementation 'org.springframework.kafka:spring-kafka'}我们再介绍使用 KRaft 启动并管理 Kafuka 集群(而非 ZooKeeper):

启动单个 broker:

首先使用

bin/kafka-storage.sh random-uuid生成 cluster ID;创建 Kafka 日志目录

bin/kafka-storage.sh format -t <cluster ID> -c config/kraft/server.properties;启动服务

bin/kafka-server-start.sh config/kraft/server.properties;

至此单个 broker 已经成功启动并且使用;

启动 Kafka Cluster:

一般情况下 cluster 由 docker compose / Kubernentes 管理;这里介绍手动启动方式,理解后就能放到这些管理工具中。

使用上面同样的方法获取 cluster ID,不过注意同一个 cluster 需要使用同一个 cluster ID 确保之后能成功连接;

在多台服务器 / 物理节点上配置

config/kraft/server[N].properties;注意,node.id、listeners端口(如果 cluster 在一台机器上)、logs.dir需要不同(N标号可有可无,但如果在一台机器上则需要不同);分别启动服务:

bin/kafka-server-start.sh config/kraft/server[N].properties;

下一步介绍如何在 Spring Boot 中编码使用 Kafka:

和 RabbitMQ 类似,在 Consumer 类中:

声明 Consumer Listener:使用

@KafkaListener(id: String, topics: String | String[], groupId: String);groupId指定 Consumer Group;声明 消息队列 Topic(和 RabbitMQ 在 Consumer 端声明交换机、队列的道理一样):在

@Configuration类(自动注入)中定义@Bean,返回NewTopic对象;其中NewTopic对象使用TopicBuilder构建;TopicBuilder重要构建方法:.name(String)设定 topic 名称、.partition(int)设定分区建议、.replicas(int)设定主从副本数;

在 Producer 类中:

使用 KafkaTemplate<TopicType,DataType>.send(topic: String, data: Object) 来发送数据;

也可以使用 KafkaTemplate.send(topic, key, data),不过接收时需要 CustomerRecord<KeyType,ValType> 来处理;

Chapter 3. Web Socket

3.1 Definitions

一种全双工(full-duplex)的应用程序协议,基于 TCP 传输层协议(意味着需要 handshakes)。

它能帮助 Web Application 摆脱传统的 HTTP 请求-响应式通信模式,使通信方式更灵活。

Server 段需要在注册服务时发布 endpoints,然后 Clients 通过 endpoints 的 URI 连接 server;

包含两个部分:handshakes & data transfer;

Clients 和 Server 可以在连接建立时互相发送消息,使用

Sec-WebSocket-key(client)和Sec-WebSocket-Accept识别连接是否可以建立;

其中 WebSocket URI scheme:ws://<host>:<port>/[path](SSL 加密 wss);

3.2 Coding WebSocket

创建一个 endpoint 类(继承于

Endpoint类型),并向ServerEndpointConfig注册它:xxxxxxxxxxServerEndpointConfig.Builder.create(<Endpoint>.class, <path String>).build();实现 endpoint 的生命周期方法(如

onOpen、onMessage、onError、onClose);有两种方法可以实现,一种是原生实现,例如:

xxxxxxxxxxpublic class EchoEndpoint extends Endpoint {public void onOpen(final Session session, EndpointConfig config) {session.addMessageHandler(new MessageHandler.Whole<String>() {public void onMessage(String msg) {try {session.getBasicRemote().sendText(msg);} catch (IOException e) { ... }});}}或者是简洁的 annotation 实现(无需继承):

xxxxxxxxxx("/echo")public class EchoEndpoint {public void onMessage(Session session, String msg) {try {/* 获取当前 endpoint 维护的所有已打开的 session *//* 但是客户端很多时,需要想办法使用多线程/多进程处理 */for (Session sess : session.getOpenSessions()) {if (sess.isOpen())sess.getBasicRemote().sendText(msg);}} catch (IOException e) { ... }}/* 可以根据发送消息类型重载多个方法 */public void binaryMessage(Session session, ByteBuffer msg){ System.out.println("Binary message: " + msg.toString()); }public void pongMessage(Session session, PongMessage msg) {System.out.println("Pong message: " +msg.getApplicationData().toString());}}向 endpoint 中添加业务逻辑;

在前端添加相应的请求代码,将 endpoint 应用在一个 Web Application 中;

下面用一个例子说明:

假设有一个需要实时显示股票信息的 Web Application,我们先定义后端的 Endpoint:

xxxxxxxxxx("/stock")public class StockEndpoint { /* 使用可并发的队列 */ static Queue<Session> sessionQueue = new ConcurrentLinkedQueue<>(); /* 定义发送方式 */ public static void send(double price, int volume) { /* 手动格式化为字符串 */ String msg = String.format("%.2f,%d", price, volume); try { for (Session s: sessionQueue) { s.getBasicRemote().sendText(msg); log.debug("Sent: {}", msg); } } catch (IOException e) { log.error(e.toString()); } } public void openConn(Session session) { /* 手动管理 session 队列 */ sessionQueue.add(session); log.info("Connection opened with {}", session.getSessionId()); } public void closeConn(Session session) { sessionQueue.remove(session); log.info("Connection closed with {}", session.getSessionId()); } public void errorHandler(Session session, Throwable t) { sessionQueue.remove(session); log.error("Connection error: ID {}", session.getSessionId()); log.error("Connection error message: {}", t.toString()); }} 然后定义 WebListener 以及用于定时触发的工具类 ReportBean(用于后端 Web Application 处理定时任务):

xxxxxxxxxx// file: StockListener.javapublic class StockListener implements ServletContextListener { private Timer timer = null; public void contextInitialized(ServletContextEvent event) { timer = new Timer(true); timer.schedule(new ReportBean(event.getServletContext(), 0, 1000)); event.getServletContext().log("The report task is added"); }}

// file: ReportBean.javapublic class ReportBean extends TimerTask { private ServletContext context = null; private Random random = new Random(); private double initPrice = 100.0; private int volume = 300000; public ReportBean(ServletContext context) { this.context = context; } public void run() { context.log("Task started"); price += 1.0 * (random.nextInt(100) - 50) / 100.0; volume += random.nextInt(5000) - 2500; StockEndpoint.send(price, volume); context.log("Task ended"); }}然后在前端完成对应任务:

xxxxxxxxxxexport default function MainPage() { const [price, setPrice] = useState("--"); const [volume, setVolume] = useState("--"); useEffect(() => { var wsocket; function connect() { wsocket = new WebSocket("ws://localhost:8080/stock"); wsocket.onmessage = onMessage; } function onMessage(event) { /* 手动解码 */ var arr = event.data.split(","); setPrice(arr[0]); setVolume(arr[1]); } connect(); return () => { wsocket.close(); } }, []); return <> <h1>WebSocket Stock Display</h1> <table> <tr> <td width="100">Ticker</td> <td align="center">Price</td> <td id="price" style="font-size:24pt;font-weight:bold;">{price}</td> </tr> <tr> <td style="font-size:18pt;font-weight:bold;" width="100">TestStock</td> <td align="center">Volume</td> <td id="volume" align="right">{volume}</td> </tr> </table> </>;}我们可能还需在此基础上继续改进,例如定制消息的编解码过程,将这段业务逻辑从 WebSocket 连接中解耦出来,还能实现代码复用。这个时候就需要我们定义 WebSocket 的 encoder 和 decoder 了;

3.3 WebSocket Encoder & Decoder

实现 Encoder.Text<T>(文本消息)或 Encoder.Binary<T>(二进制消息)其中一个接口:

注:解码器就是

Decoder.Text<T>和Decoder.Binary<T>;

xxxxxxxxxxpublic class MessageATextEncoder implements Encoder.Text<MessageA> { public void init(EndpointConfig ec) { }

public void destroy() { }

public String encode(MessageA msgA) throws EncodeException { // Access msgA's properties and convert to JSON text... return msgAJsonString; }}xxxxxxxxxxpublic class MessageTextDecoder implements Decoder.Text<Message> { public void init(EndpointConfig ec) { } public void destroy() { } public Message decode(String string) throws DecodeException { // Read message... if ( /* message is an A message */ ) return new MessageA(...); else if ( /* message is a B message */ ) return new MessageB(...); } public boolean willDecode(String string) { // Determine if the message can be converted into either a // MessageA object or a MessageB object... return canDecode; }}然后在 @ServerEndpoint(value = <path>, encoders = {}, decoders = {}) 中指明添加的编解码器,并使用 Session.getBasicRemote.sendObject() 发送;

接受端的 onMessage 函数参数除了 Session 以外,还需要适配解码器输出的数据类型。

3.4 STOMP over WebSocket

我们现在知道如何在 Web Application 中使用 WebSocket 了,但如果有更高阶的需求呢?例如,如果我想模仿发布-订阅模式对一类 clients 发送消息,或者说为 WebSocket 添加一个含 topic 的消息队列的高级包装,应该怎么办?可以考虑使用 STOMP 来完成这个需求。

后端以 Java Spring 为例,先引入依赖:

xxxxxxxxxxdependencies { implementation 'org.springframework.boot:spring-boot-starter-websocket'}其内置了 STOMP(simple/stream text oriented message protocol 流式文本定向消息协议),这种协议基于 Web Socket 规范了简单的面向文本的消息传输的方案/机制。

然后对于前端需要引入:

xxxxxxxxxxnpm install stompjs sockjs-client @types/sockjs-client加入项目的方法分几步:

配置 Web Socket Endpoint 以及 STOMP 的 broker 信息:

xxxxxxxxxxpublic class WebSocketConfig implements WebSocketMessageBrokerConfigurer {public void configureMessageBroker(MessageBrokerRegistry config) {/* 设置 in-memory 的 WebSocket 消息传输队列的 path */config.enableSimpleBroker("/topic");/* 设置 WebSocket 处理前端主动请求的 path 前缀 */config.setApplicationDestinationPrefixes("/app");}public void registerStompEndpoints(StompEndpointRegistry registry) {/* 设置 WebSocket STOMP 监听服务运行在哪个 endpoint 下 */registry.addEndpoint("/websocket-endpoint").withSockJS();}}配置 Web Socket 消息处理方法(WebSocket 处理前端主动请求的方法体):

xxxxxxxxxxpublic class MessageHandler {/* 接受前端主动请求的 path 地址(不包含前缀) */("/send")/* 从后端要将处理好的消息放到消息传输队列的指定 path 上 */("/topic/messages")public Message sendMessage(Message message) {return new Message("Hello, WebSocket!", "System");}}最后在前端编写代码,例如主动请求后端并通过订阅 STOMP 消息队列(这种订阅的方式是 STOMP 规定的),来接收后端传来的消息,并且通过设定的端口主动向后端发送 WebSocket 请求:

x/* 使用 sockjs-client 库传入 WebSocket endpoint 以方便之后建立连接 */var socket = new SockJS('/websocket-endpoint');/* 基于当前 WebSocket 配置创建 STOMP 客户端 */var stompClient = Stomp.over(socket);/* 根据 STOMP 协议建立连接,配置订阅函数(指定后端发消息后的 handler) */stompClient.connect({}, function (frame) {stompClient.subscribe('/topic/messages', function (message) {var messagesList = document.getElementById('messagesList');var listItem = document.createElement('li');listItem.textContent = message.body;messagesList.appendChild(listItem);});});/* 主动向后端发送消息的函数 */function sendMessage() {var messageInput = document.getElementById('messageInput');stompClient.send('/app/send', {}, messageInput.value);messageInput.value = '';}

上面就是大致的接口和使用方法。不过这些接口还可以有一些使用经验技巧,能够完成一些特殊的需求。例如:

实现实时消息传递:无论是从前端传来的消息,还是后端向前端发送的消息,都能呈现在前端。这可以通过新建一个 STOMP 消息 topic / 新建请求 endpoint 来解决;

实现群发消息(消息队列广播):更改

StompEndpointRegistry的 Delivery Mode 即可:xxxxxxxxxxpublic void configureMessageBroker(MessageBrokerRegistry config) {config.enableSimpleBroker("/topic");config.setApplicationDestinationPrefixes("/app");config.setBrokerDeliveryMode(MessageBrokerRegistry.BrokerDeliveryMode.BROADCASTING);}这样后端发往

/topic/*的消息会被广播到所有客户端。

Chapter 4. SQL 数据库进阶:事务

4.1 Definitions of Transaction

定义:事务是一系列必须全部成功完成的操作,否则每个操作中的所有更改都将被撤消。事务以提交或回滚结束。

目标和意义:它的目的很简单,也非常重要:通过确保成批的操作要么完全执行,要么完全不执行(包装原子操作),来维护数据库 / 应用程序数据 / 其他分布式状态的完整性 和 一致性。

因此事务具有原子性、一致性、隔离性(函数隔离)、持久性,四者合称 ACID。

讨论范围:以数据库为首的 Resource Manager(后面介绍)在持久化资源时的行为。

事务的特性 ACID:

Atmoic:事务是一个原子操作单元,要么操作完全不执行,要么全部执行;

Consistent:事务开始前和结束后,确保系统状态是一致的;

注:“确保系统状态的一致性” 主要指:

确保不会有的状态是处理后的,而有的是处理前的;

施加的所有数据约束在事务执行前后必须得到满足,不能被破坏;

Isolated:执行数据操作的系统提供一定的隔离机制,确保事务不受外部并发操作影响 而 “独立” 执行;

举例:两个不同事务并行执行,二者修改同一状态数据。这个时候在任一事务内部,不会出现某一状态不修改就改变的情况;

Durable:事务提交的修改是持久化的。这确保事务一旦 commit,哪怕系统故障也能保持。

操作:

事务(transaction):需要定义一个事务 从哪里开始,到哪里结束;

回退(rollback)指撤销指定事务的过程,通常回滚到前面某个检查点,或者事务开头;

提交(commit)指将未落盘的事务处理的状态 / 结果写入数据库表(持久化);

4.2 Problems of Transaction for Database I: Isolation

考虑一个问题,有没有可能多个事务操作一个数据状态?

这个问题一般出现在数据库中,因此特别地,下面的问题都在讨论数据库的事务处理。

肯定是有的。这样就可能会发生数据读写的问题:

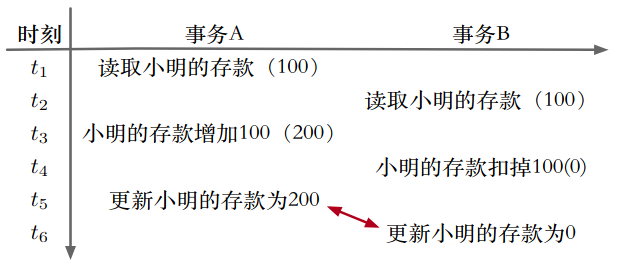

4.2.1 Conflicts

脏写(dirty write):两个事务写同一个数据,造成数据不一致性;

此级别连最基本的并发保护都没有,现实中不可能有数据库允许这么设计。

就是 “写写冲突” 导致脏写:

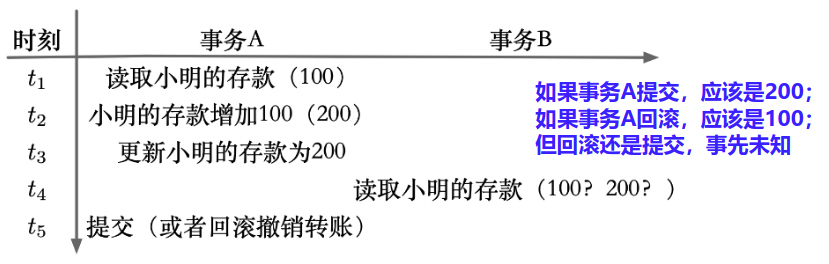

脏读(dirty read):一个事务读到另一个事务修改后但未提交的数据。如果 “另一个事务” 撤销了修改操作,就会造成数据不一致性;

就是 “写读冲突”、 导致脏读、脏写:

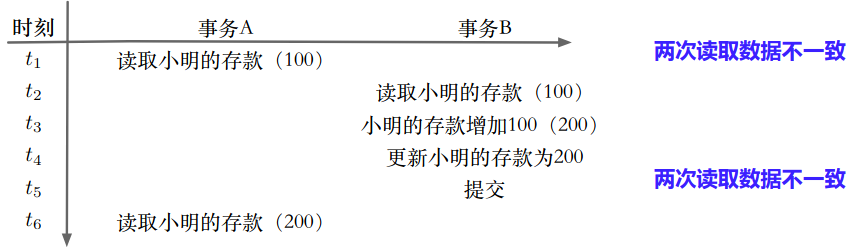

不可重复读(unrepeatable read):一个事务在另一个事务修改记录的操作前后读的结果不一致(同一个数据的修改);

就是 “读写冲突” 导致不可重复读:

幻读:一个事务在另一个事务添加、删除记录的操作前后查找的结果不一致(数据记录的增删);

问题的严重性从上到下依次减弱。

在 MySQL 中,使用的默认事务引擎是 InnoDB,可以用于处理大量短期事务(尤其适合的扁平事务)。那么 MySQL 是如何解决以上的问题的呢?

注:扁平事务 Plain Transaction,这种事务通常的操作周期很短,比较少发生回滚事件。

4.2.2 Isolation Level

在事务引擎中存在 4 个事务隔离级别:

| Isolation Level | Dirty Read | Unrepeatable Read | Phantom Read |

|---|---|---|---|

| Read Uncommitted | YES | YES | YES |

| Read Committed | NO | YES | YES |

| Repeatable Read | NO | NO | YES |

| Serializable | NO | NO | NO |

Read Uncommitted:在这个隔离级别下,事务引擎允许一个事务读到另一个事务未提交的更改,性能最好,但麻烦最大(没有采取任何隔离措施,3 个问题都存在);

Read Committed:在这个隔离级别下,事务引擎只是不允许一个事务读到另一个事务未提交的更改,解决了脏读,但是仍然会出现不可重复读、幻读的问题;

Repeatable Read:MySQL InnoDB 默认的事务隔离级别。在这个隔离级别下,事务引擎提供给单一事务的数据是保持不变的(即第一次读的结果会像被缓存起来一样);

Serializable:强制事务串行化,读取每一行数据都加锁。此隔离级别下会严重影响性能。但是在一些连幻读都不允许的场合下有用。

隔离级别的性能从上到下依次降低,但是处理问题的有效性依次上升。

数据库使用方应该根据业务场景进行 trade off,最后在数据库连接上说明配置;

4.2.3 Implementations of Isolation in DB I: Locks

现在我们考虑,数据库如何实现这些隔离级别。

其实,数据库和普通程序在处理数据并发问题的思路是类似的:加锁。

我们记两个同时发生的事务 A、B,共同访问资源 R。现在有几种锁 / 措施可以选择:

read lock:读锁,事务 A 加这个锁,则未提交前:A 在读 R 时,B 无法写 R(可以防止 A 出现 Unrepeatable read。但如果 B 不加锁,B 就会 unrepeatable read);

write lock:写锁,事务 A 加这个锁,则未提交前:仅 A 在写 R 时,B 无法写 R,但 A 和 B 都可能发生脏读(读到这个脏数据);

exclusive write lock:互斥写锁,事务 A 加这个锁,则未提交前:仅 A 在写 R 时,B 既无法读、也无法写 R(可以同时防止 A、B dirty read);

snapshots:数据快照,每个事务开始前创建一份当前的数据快照;可避免 3 种隔离问题,但可能导致数据不一致,需要额外处理;

于是利用上面的措施,我们尝试实现这些隔离级别:

如果多线程同时操作一个数据,不作任何隔离措施,MySQL 数据内存缓存共享(因为同进程)、硬盘也共享。此时出现脏写及其他所有问题。这个时候可以通过给写的记录加 long duration write lock(可读);加锁后是 Read Uncommitted,会出现 dirty read;

如果多线程同时操作一个数据,不共享内存数据,并且给该数据加读锁+写锁(read & write lock,只能读,释放前不能写)。这就是 Read Committed 级别,另一个线程可能出现 unrepeatable read;

另一个线程可能看到数据是 A 状态,等下一时刻可能就读出 B 状态了;

如果多线程同时操作一个数据,不仅不共享内存,而且给该数据加互斥写锁(不能读不能写)。这就是 Repeatable Read 级别,但当前线程可能出现 phantom read;

一个线程如果在事务中途修改其他记录,那么另一个线程在事务中查询记录的结果就不一样了;

如果多线程同时操作一个数据,不仅不共享内存,而且给:

这个数据所在的整个表加互斥写锁(称 “表锁”);

或给适用于某种查询条件的记录加互斥写锁(称 “谓词锁”);

或为每个事务创建 snapshot + 版本管理和后处理。

这就是 Serializable 级别;

4.2.4 Implementations of Isolation in DB II: MVCC

除了用锁实现隔离级别,以 MySQL 为首的数据库大多还使用 MVCC 的机制。

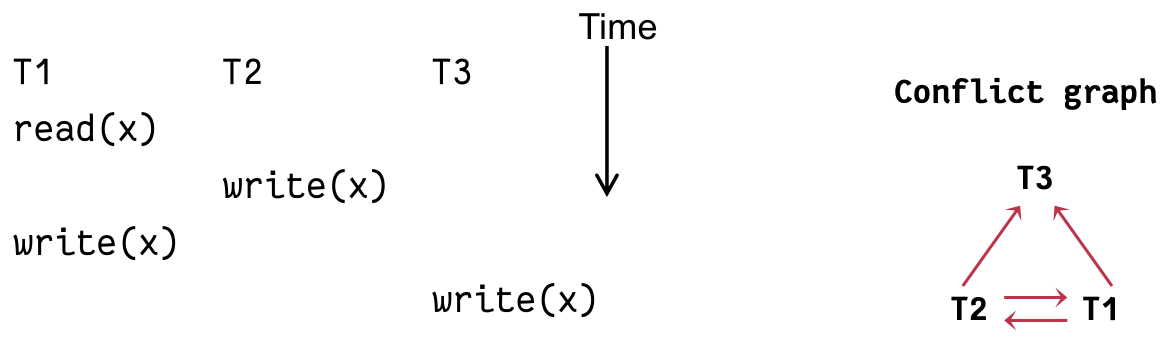

4.2.5 Implementations of Isolation in DB III: Scheduling

两个事务如果真的要同时操作一个数据,就一定需要报错吗?能否通过某些手段正确地完成双方的并行操作?

事实上真正的数据库想要实现隔离环境下的并发,不仅仅依赖于锁,还可以使用合适的调度策略来完成。

或者我们可以从另一个理论层面表达:“是否真正需要报错”。我们现在从理论层面探究:什么时候并发处理会出错(不可串行化调度)、什么时候可以通过适当的调度策略实现完美高效的并发(可串行化调度)。

为了更好地解释并发控制过程中,数据库对事务的处理流程,首先引入一个概念:调度。调度为事务的并发过程中,决定事务中每个操作的执行顺序。

为了方便讨论,我们将所有操作抽象为读、写操作(使用读写序列描述事务执行过程)。例如更新:read(X) -> offline edit(X) -> write(X);

这样数据库调度问题,就是数据库决定哪一种读写序列是正确的。

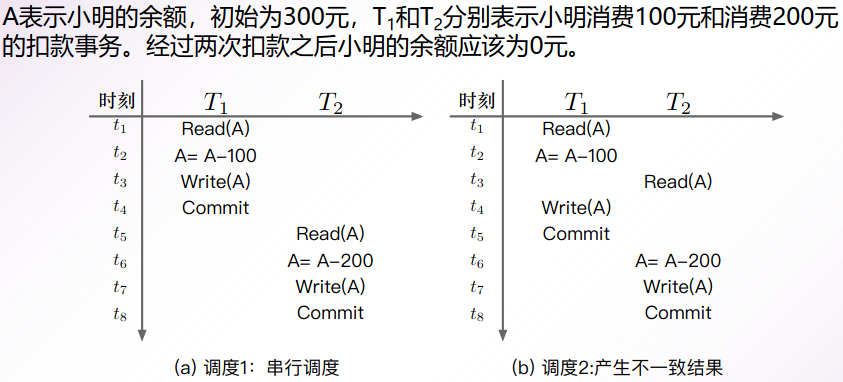

考虑一次场景的两种调度:

第一种调度恰好是事务的串行执行,因此被称为 “串行调度”;第二种调度是某一种(没有锁措施)事务的并发执行,被称为一种 “并发调度”;

我们定义哪些事务能够通过适当的调度实现高效并发:

给定一个并发调度

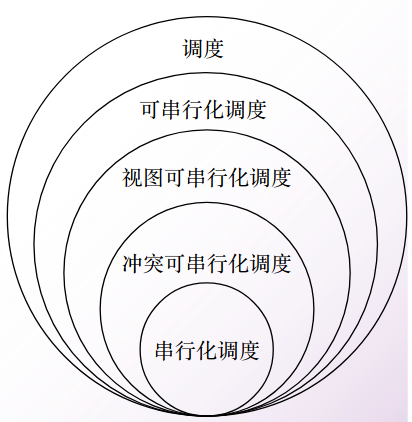

可串行化调度的数量十分巨大,且难以校验,数据库中一般通过找到可串行化调度的子集(充分条件),即找到能够提前确认是可串行调度的并发调度,进而提升调度效率;

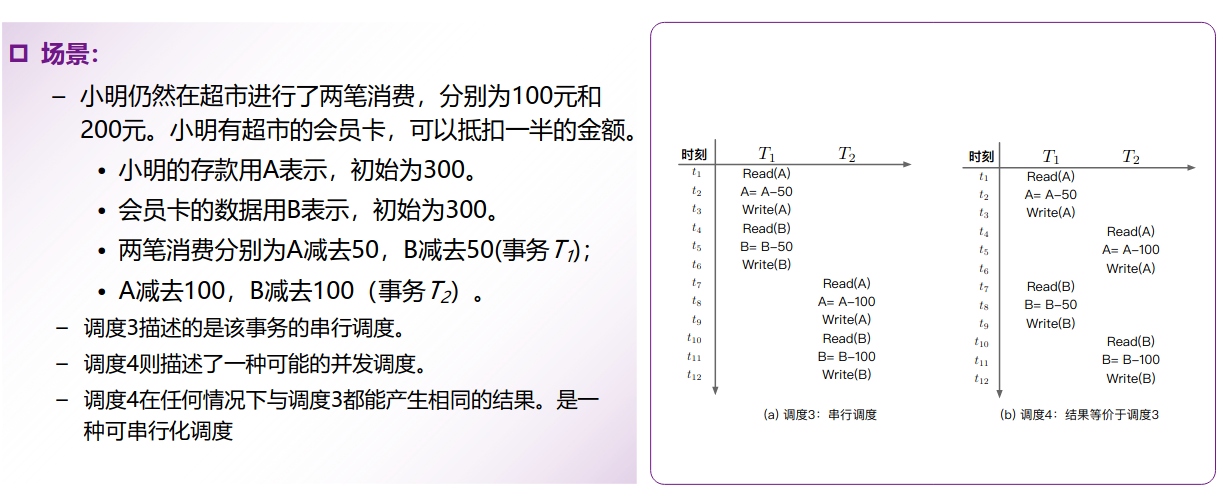

再考虑一个例子:

这种事务场景下,我们找到了(存在)一种并发调度方案(4)使得它与串行调度方法的结果是一致的,因此我们认为这个(4)调度方案是可串行化的调度(就是说,这种并发的调度可以实现和串行化一样的效果)。

那么如何判断一个调度是否可串行化?如何实现可串行化调度(也就是用性能好的并行调度实现串行化的效果)?就像前面介绍的,我们一般通过充分条件找容易验证的方案:

终态可串行化:如果两个调度方案的结果一致,则一定是可串行化的调度;

例如,我们上一章在 Serializable 的实现中,“为每个事务创建 snapshot + 版本管理和后处理” 就是一种通过 “先执行” 的方式,来在试探可串行化性。如果不可串行化则向一方发出异常,或者其他解决方案。

冲突可串行化:直接判断调度方案的操作间是否冲突。不冲突则一定是可串行化调度;

视图可串行化:判断事务操作流程是否一致(初始化读、读写顺序、最终写的一致性),一致则是可串行化调度;

其属性关系如下:

这里讨论一下 “冲突可串行化” 的判断方案:操作交换。我们定义:交换事务相邻两操作的顺序,如果不改变最终结果相同,则称这是一次等价交换(两个调度是等价的)。并且,如果调度

这相当于建立了一个等价类。就像你在解线性方程组,初等行变换不会改变最终结果,因此 “初等行变换” 是秩等价变换。

另外,我们在实际进行交换操作时,可以通过判断交换后是否会产生上面的 3 种冲突(写写冲突、写读冲突、读写冲突)。

根据交换等价以及 冲突可串行化调度的定义,我们直接有结论(通过等价类理解):若冲突可串行化调度

因为这个保序性,由离散数学的理论,我们可以借助拓扑排序描述等价类间互不可等价交换的关系,称 “优先级图”。若调度

数学上可以证明:这个图有环等价于

这也是可串行化调度中,最容易代码实现、并验证的一种。因此多数数据库采用这种方式,结合 2PL(2-phase lock)来实现事务隔离机制。

另一个是视图可串行化调度,它的条件更宽松,因此也能识别更多的可串行化调度,但是它的计算难度更大。

这种情况有可能是 “盲写”。也就是某个事务的写直接覆盖了共享资源上一个写,期间不存在读操作。如下:

也就是这时 T1 -> T2 边可以被 “擦掉”。或者说,这三个事务本质上是可串行化的(视图可串行化)。

但识别这个事没有好的方法,只能穷举,因此我们说冲突可串行化更容易判断。

4.2.6 补充:Design Pattern of Locks

以上的隔离级别在数据库中自行帮我们实现。实际上,事务的锁还可以有其他的设计模式。

例如实现 Repeatable Read 级别时,数据库使用 exclusive write lock 锁定正在写的记录,这就是一种悲观锁。不过我们也可以使用乐观锁来实现这个目的。

数据库访问中,这几类锁(或者说设计模式)能充分利用现有的知识,提高数据的访问效率:

乐观离线锁(Optimistic Offline Lock):如果使用的 workload 的访问模式中,读远多于写,这个时候可以乐观地认为一个数据很少需要保护(写回的概率很低,那么写回冲突的概率会更低)。所以这种锁不会真的锁定数据,而是:

完全开放数据读的请求;

应用写数据时,规定应该先读入应用内存,在其中做完修改操作(离线写),最后再提交更改给数据库;

在每一个记录后追加版本号的字段,初始为 0,由数据库本身控制;数据库在真正写之前检查应用写数据中的版本号和这条记录当前版本号是否一致。只有一致才允许写入,并且自增版本号;否则向写的一方抛出错误;

悲观离线锁(Pessimistic Offline Lock):如果使用的 workload 访问模式中,写多于读,这个时候悲观地认为一个数据被离线地读走,很可能是正在进行写操作。所以这种锁是真的锁,在一条记录被读走的时候上锁,其他任何线程来访问(读 / 写)这条记录都会抛出错误;

上面讨论的是在一条记录 / 一个表的层面的锁可以如何设计。如果我想跨表锁住整片对象呢?

粗粒度锁(Coarse-Grained Lock):在锁住一条记录的同时,一同锁住与其关联的其他记录 / 对象(跨表加锁)。粗粒度锁也分悲观和乐观:

乐观粗粒度锁的实现方法,可以是让关联的记录对象全部持有一个共享的版本对象。在成功更新任一记录时就自增这个版本号,能实现目标效果;

悲观粗粒度锁的实现方法,可以是让关联的记录对象全部持有一个共享的版本对象,并且在一个线程读走这个对象任一字段时,给这个版本对象上细粒度互斥写锁。这样下一个线程读关联字段后会发现共享的版本对象无法读取并抛出错误。

举例:

网上书店下达订单的过程,适用于乐观离线锁。大部分人在浏览书籍,只有少部分人真正正在下订单,而且修改的是各自购物车 / 订单的数据,很少买同一本书,冲突的概率会更低;

记录用户访问次数的过程,适用于悲观离线锁。在没有缓存的情况下,用户每访问一次几乎都会触发一次写操作,如果用乐观锁,那么频繁的错误处理会降低事务的效率。

4.3 Problems of Transaction for Database II: Atomicity & Consistency

4.3.1 Rollback & Faults Recovery

讨论完数据库如何实现隔离性之后,我们再讨论一下数据库如何实现事务的原子性和持久性。或者说:数据库是如何实现事务回滚、故障恢复的。

故障类别:

事务故障(原子性可能破坏):数据库事务因为资源冲突或者死锁等原因导致执行失败;

系统崩溃(原子性和持久性可能破坏):数据库自身或操作系统的故障导致数据库进程意外退出;

磁盘故障(持久性可能破坏):数据因为磁盘(其他非易失性存储)损坏导致无法被读取;

自然灾害(持久性可能破坏):自然灾害对数据库系统所在的环境造成了彻底性破坏。

补充:系统的高可用指标

通用高可用指标:

平均故障间隔时间 MTBF(Mean Time between Failures):系统在两相邻故障间隔期内正确工作的平均时间;

平均恢复时间 MTTR(Mean Time to Repair):系统平均从故障中恢复需要的时间;

平均损坏时间 MTTF(Mean Time to Failure):系统出现损坏的平均时间;

数据库容灾指标:

恢复点目标 RPO(Recovery Point Objective):业务系统在系统故障后所能容忍的数据丢失量;

恢复时间目标 RTO(Recovery Time Objective):业务系统所能容忍的业务停止服务的最长时间;

4.3.2 Implementation of Atomicity & Consistency in DB: Logs

为了应对上面的问题,一般情况下数据库的应对机制概括如下:

| 问题类型 | 出现频率 | 对事务的影响 | 解决思路 |

|---|---|---|---|

| 无故障下事务回滚 | 高 | 原子性 | 单机数据库恢复 |

| 事务故障 | 较高 | 原子性 | |

| 系统崩溃能重启 | 中等 | 原子性/持久性 | |

| 系统崩溃不能重启 | 低 | 持久性 | 一主多备 |

| 磁盘故障 | 低 | 持久性 | 数据多副本 |

| 自然灾害 | 极低 | 持久性 | 异地多机恢复 |

我们详细讨论数据库针对上面的情况作出的具体解决方案:

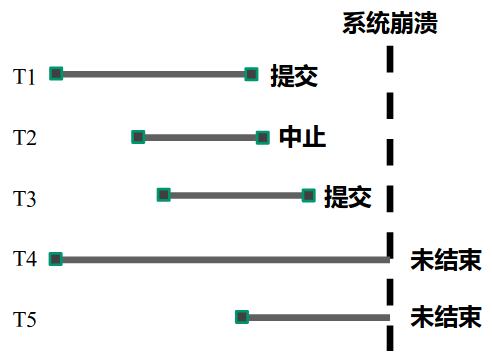

A. 事务故障 / 系统崩溃

先定义一些概念:

脏页:内存页面已更新,磁盘页面未更新;

刷脏:将内存脏页刷到磁盘;

原因:可能是 操作系统中止/软件故障、死锁等等。

考虑下面的例子:

T1 和 T3 在崩溃前已经提交了事务。是否说明不会有问题了呢?

不一定。在 T1/T3 提交事务后,不一定会完成落盘(分布式系统更需要考虑这个情况)。如果崩溃时没有落盘,就需要 重做(redo,以保证持久性);

同样的道理,T2 如果在进行事务时,存在落盘操作(可选的策略),但是在中止(回滚)事务后、崩溃前没有来得及重新刷盘(恢复数据,以保证一致性),则也需要 重做;

T4/T5 在崩溃时刻并没有结束事务,则考虑它们是否落盘,如果落盘了就一定需要回滚当前事务已做的部分(恢复到进行事务前的状态,以保证原子性);不落盘就皆大欢喜。

针对上面的策略,我们已经发现了有几种不同的刷盘策略了:

为了保证原子性,未结束事务可以采取两种刷盘方式:

NO-STEAL(非窃取):未结束事务不能将脏页写入磁盘;

优点:不存在原子性问题,这样一举解决 T2、T4、T5 可能存在的关于原子性的隐患;

缺点:事务执行过程中不能刷新磁盘,因此必须占有较大的缓冲区空间,不利于多个事务的并发执行;

STEAL(窃取):未结束事务能将脏页写入磁盘;

优点:增大多个事务的并发能力,提升消息吞吐量;

缺点:影响原子性,需要回滚(考虑上面的 T2/T4/T5 的情况);

为了保证持久性,已完成事务可以采取两种刷盘方式:

FORCE(强制):已完成事务强制将脏页写入磁盘,这也是为了保证持久性大家最常想到的;

优点:不存在持久性问题,解决 T1/T3 的关于持久性的问题隐患;

缺点:每次事务提交都必须刷新脏页,消耗大量 IO 读写资源;

NO-FORCE(非强制):已完成事务不强制将脏页写入磁盘,影响持久性,需要重做(优缺点与 FORCE 相反);

最终,“重做” 交给一个文件结构 redo log(重做日志)、“回滚” 交给另一个文件结构 undo log(回滚日志);

| Aspects | FORCE(事务提交强制刷盘) | NO-FORCE(事务提交非强制刷盘) |

|---|---|---|

| NO-STEAL(执行期间不刷盘) | ❌ redo log & ❌ undo log | ✅ redo log & ❌ undo log |

| STEAL(执行期间可刷盘) | ❌ redo log & ✅ undo log | ✅ redo log & ✅ undo log |

补充:数据库日志的实现方式

那么在众多策略中,MySQL 这种主流的数据库管理系统采用的是什么策略?

答案是 STEAL 配合 undo log + NO-FORCE 配合 redo log(刷盘时机:全部异步刷盘);

注:刷盘时机设计

数据库关闭时,缓冲区中的所有脏页需要写回磁盘;

缓冲区中的数据页面已经满了,如果需要继续读入数据页面,就必须将被替换的脏页写回磁盘;

数据库会设置一个单独线程定时刷脏(全量 / 增量);

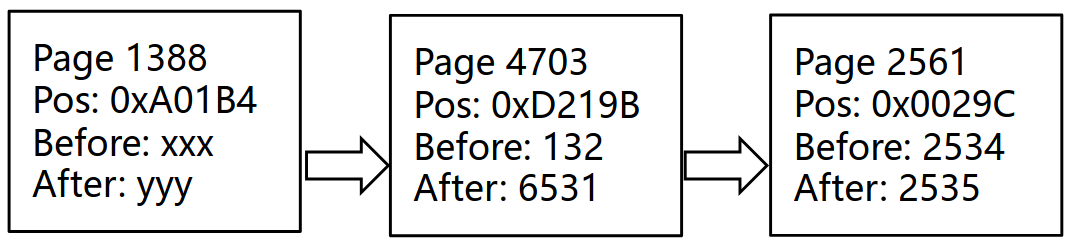

知识补充:日志、数据库日志、预写日志

日志是日志记录(log record)的序列,也是一种数据结构。所有的日志内容顺序写入磁盘,写入后不会修改(即不会随机写),能保证高效的写入效率。正因为这个特性,所以才有学者提出 LSM Tree(Log-Structured Merged Tree)作为一种高效键值存储数据结构;

数据库日志是数据库系统内一系列执行事件的记录,它与数据库事务是密切相关的,事务的执行过程会反映在日志中,数据库可以通过对日志的分析实现对事务的回滚(原子性)或重做(持久性);

预写日志(Write Ahead Log),即日志先于数据写入硬盘。这样可以确保在系统崩溃重启后有效恢复。

数据库日志的共性是:

都会对事务开始、提交和中止进行记录(

都需要满足预写日志(WAL)的条件。例如 undo log 需要在事务执行期间的刷盘动作前写回、redo log 需要在事务提交落盘前写回;

按照我们上面对数据库日志的需求来讨论:

Undo Log(回滚日志):

结构:

产生时机:当事务

write(X))时产生;作用:实现事务回滚;

Redo Log(重做日志):

结构:

产生时机:和 Undo Log 一样在

write(X)时产生;作用:实现事务重做;

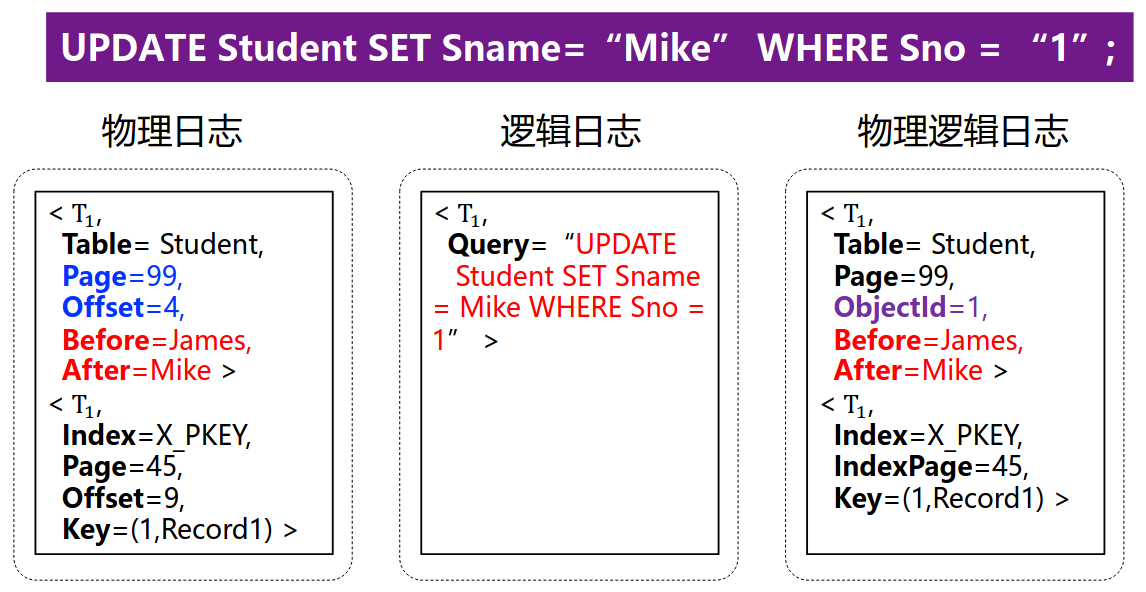

除了按照 undo/redo 的功能区分日志,为了进一步了解这些日志本身的实现,还需要从日志性质上分类并讨论:

逻辑日志:记录事务中高层抽象的逻辑操作(例如:例如小明的年龄由20改成21);

物理日志:记录数据库中数据项的具体物理变化,例如针对某个数据项,其存放的真实物理参数(如物理磁盘位置、数据结构偏移量等)一系列变化:

物理逻辑日志:一种结合了物理日志和逻辑日志的混合描述方法。包含了数据页面的物理信息,但是页面以内目标数据项的修改信息则是以逻辑方式记录(例如:第100个页面(物理)的小明年龄值由20改成21(逻辑));

比较一下 3 种日志:

其实无论从哪个方面分,数据库日志评判的 3 个重要性质,分别是:

幂等性:一条日志记录无论执行一次或多次,得到的结果都是一致的;

失败可重做性:一条日志执行失败后,是否可以重做一遍达成恢复目的;

操作可逆性:逆向执行日志记录的操作,可以恢复原来状态(未执行这批操作时的状态);

我们再借助这 3 条特性来对比这 3 种日志:

| Aspects | 解析速度 | 日志量 | 可重做性 | 幂等性 | 可逆性 | 应用场景 |

|---|---|---|---|---|---|---|

| 物理日志 | 快 | 大 | ✅ | ✅ | ❌ | redo log |

| 逻辑日志 | 慢 | 小 | ❌ | ❌ | ✅ | undo log |

| 物理逻辑日志 | 较快 | 中 | ✅ | ❌ | ❌ | undo log |

逻辑日志不具备幂等性:执行两次日志中的插入动作,状态会不断改变;

逻辑日志也不具备失败可重做性:因为数据库有索引设置。如果在操作

INSERT X附近系统崩溃,并且只对索引产生影响,但数据页面是正常的,但逻辑日志中会记录INSERT X,这会导致数据重做后不一致;逻辑日志具备可逆性:将记录的高级操作反过来执行就能达到撤销操作的目的;

因此逻辑日志不能用来作为 redo log,只能作为 undo log(回滚);

物理日志不具备可逆性:无法处理数据项位置变化的情况。例如 Database 中的 B+ 树结点分裂导致数据页面页号出现变动、并且数据偏移量还可能因为后续数据的插入而变动。这样就不能像逻辑日志一样反过来执行;

物理日志具备幂等性:是因为在重做时,哪怕是

INSERT操作也是向同一物理位置写同样数据,因此是幂等的;物理日志具备失败可重做性:即便数据库有索引,并且崩溃导致索引和数据页面不一致,但按照记录的物理位置从初始状态一步步重做插入,一定能还原到相同状态;

因此逻辑日志一般用于 redo log;不能用于 undo log;

另注:物理逻辑日志用于回滚时,特别是索引页面分裂,可通过页面前后指针来完成回滚;

具体实现方法:

NO-STEAL + FORCE: shadow copy 算法;

STEAL + FORCE:基于 undo-log 的恢复算法;

不需要考虑事务重做(no redo);

在故障后恢复 / 事务回滚时,需要:

反向扫描 undo-log,找到所有未完成的事务(没有 commit/abort 闭合 start 块的事务);

对每一个未完成的事务,按日志中的顺序从后到前,一步步执行抵消的操作(使用

在执行结束抵消操作后,写入该事务中止的日志(

STEAL + FORCE 方法的局限性:

每次事务提交都需要强制刷盘,造成随机页面读写多,性能差;

难以实现主备数据同步;

NO-STEAL + NO-FORCE:基于 redo-log 的恢复算法:

不需要考虑事务回滚(no undo);

事务提交时将日志刷盘;

在故障后恢复,需要:

正向扫描 redo-log,找到所有已完成的事务;

如果已 Commit 的事务已经刷盘,可以不用重做。后续通过 checkpoint 检查点机制来判断是否刷盘,从而可以实现刷盘的事务不需要重做;

如果遇到未 Commit / abort 的事务,也可以不用重做;

如果已 Commit 的事务未刷盘,则进行下一步;

重做这些已完成的事务的每一步骤,写入日志;

写入未完成事务结束的日志;

NO-STEAL + NO-FORCE 方法的局限性:

事务并发受限:事务执行期间不能刷盘,那么 buffer 满了后就需要等待;

一个提交的事务和一个未提交的事务都改了某个页面,请问是否应该将这个页面刷盘呢?

STEAL + NO-FORCE(最终方案):基于 redo/undo log 的恢复算法;

在故障恢复时,需要:

反向扫描 undo log、正向扫描 redo log,出现没有闭合的

<T start>则判定为未完成事务、反之是已完成事务;重做阶段:在正向扫描 redo log 后按序将已完成(标注重做)的部分再次执行(重放历史)、未完成部分插入

<T abort>;撤销阶段:在反向扫描 undo log 后将未完成(标注回滚)的部分撤销执行,并插入

<T abort>。

补偿日志机制:为了防止在恢复过程中再次崩溃而不知晓恢复的进度,人们设立 “补偿日志”,每次执行 undo 日志记录后,数据库需要向日志中写入一条补偿日志记录(compensation log record,CLR),记录撤销的动作,也就是实现了 undo 日志的 redo,记录已经 undo 的日志,保证 undo 不被重复执行;

检查点机制:数据库的日志会随着事务的执行不断变长,这会使恢复时间也相应地变长,需要压缩日志大小来降低恢复的时间。人们因此设计了一种检查点(checkpoint)机制,检查点定义了一个脏页刷盘的时刻,要求检查点之前的日志记录对应的缓冲区数据页面修改已经刷新到磁盘。这样:

在检查点之前完成(commit/abort)的事务不需要处理;

在检查点之后 commit/abort 的事务需要重做;

所有未完成的事务(不含commit/abort)需要回滚;

4.4 Problems of Distributed Transaction in Different Database (Atomic)

这里我们继续讨论数据库事务。上面关于事务隔离性、原子性和持久性的解决方案还算好懂,那么我们能说完全掌控事务了吗?

可惜没有。有一类重要并且比较困难的事务:分布式事务,它尤其难以保证 ACID。为什么?主要是因为我们上面的措施大多是都是针对单个数据库中执行的事务。

如果是在多个数据库(多个数据源)中的操作组成的事务,我们想保证这个事务的原子性就比较困难,因为事务的 Part A 在一个物理节点上完成,Part B 在另一个物理节点上故障了,那 Part A 是很难感知到另一个物理节点的 Part B 的故障的。

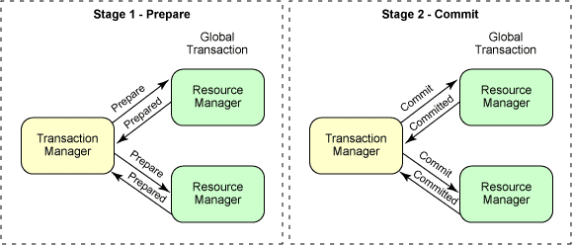

为了保证分布式事务的原子性,人们提出了 Two-Phase Commit 的机制。在分布式事务提交前,实现了 two-phase commit 的事务管理框架会做两件事:

事务管理框架会分别向多个数据源发送检查申请。只有所有数据源都为事务准备就绪,才会进入下一阶段;

事务管理框架接着逐一质询多个数据源 “事务是否可以提交”,并采取一票否决制:任何一个数据源需要回滚时,事务管理框架会决定全局事务全部回滚;

只有当事务管理框架在质询结束、确定决策,并且回复各个数据源,各个数据源才能继续进行提交或回滚操作;

注:Resource Manager 不仅仅指数据库。只要是支持事务的系统,在这里都可以称为 Resource Manager。例如邮件服务器、消息中间件等等。现在我们讨论的事务可以从数据库事务抽象为一般 Resource Manager 的事务。

好,这里考虑最坏情况。如果第 3 步发送决策信息时网络中断了:

假设

能提交、 需要回滚,然后事务管理框架在向 或 发送回滚信息时与 的连接掉线了,导致 事务超时。 注意,因为事务的隔离级别造成的性能消耗,所以一般情况下事务总是设定了超时时间。事务超过超时时间后会对提交和回滚操作进行猜测。

所以在

超时后,如果 猜测应该进行事务提交(有概率猜错),就会造成不一致性,并且事务原子性失效。 这种错误概率相当小(因为可以做重连等补救措施),但很难避免:如果你要更强的校验机制,那就会降低性能以及可用性。这也是分布式系统的 CAP 问题。

又由于日志中会体现超时的警告,因此可以后续人为地修复数据一致性。

所以总结:分布式事务的 Two-Phase Commit 协议不能避免 stage 2 网络或其他原因引发的启发式错误,进而导致的数据不一致性。分布式事务始终是有概率出错的。

Sidebar:在 Spring 框架中,Spring IoC Container 如果发现同一个事务内部操作了两个不同的数据源,则会被判定为一种分布式事务,进而使用 Two-Phase Commit 协议,不需要在业务逻辑层面进行适配。

另外,请注意区分 Two-Phase Lock 和 Two-Phase Commit。前者作为 Lock 可以是帮助实现数据库事务隔离性的一种方法;后者是分布式事务原子性的保证协议。

4.5 Transaction in Spring

总结:

| Propagation Type | 当前线程存在事务 | 当前线程不存在事务 |

|---|---|---|

| REQUIRED_NEW | ❗️挂起,创建新的,结束后恢复 | ✅ 创建新事务 |

| REQUIRED | ✅ 加入当前事务 | ✅ 创建新事务 |

| SUPPORTS | ✅ 加入当前事务 | 🚫 没有动作 |

| MANDATORY | ✅ 加入当前事务 | ❌ 抛出异常 |

| NOT_SUPPORTED | ❗️挂起,不创建新的,结束后恢复 | 🚫 没有动作 |

| NEVER | ❌ 抛出异常 | 🚫 没有动作 |

注意,以上注解如果针对 Method,那么会在方法的生命周期两端进行(方法进入、方法退出)检查。

Chapter 5. SQL 数据库进阶:优化

SQL Engine 会将 SQL 通过 Query Plan 进行类似编译优化的步骤再执行;

SQL 会将通过 Query Plan 得到的查询结果缓存(cache);

优化思路如下:

数据库表的结构是否恰当?更具体地:

每一列的数据类型(Number 使用 Integer 8 bytes 还是 String 11 bytes?Char 还是 Varchar?);

是否对正确的列建立合适的索引?

对 title / author / price 哪种数据建立索引更有利于查询?

是否使用合适的存储引擎?

例如 MySQL 中支持事务的引擎 InnoDB 和并发性能好的引擎 MyISAM;

每个表是否有合适的行格式?

是否动态:还是以 Char/Varchar 为例,究竟是节约空间、牺牲查询性能,还是将表构建得更规则,空间换时间?

是否进行压缩:数据库很多记录前面一部分列都相同,能不能就存一份?

使用什么锁机制?使用什么隔离级别?

如何在内存中为缓存配置合适大小?

硬件级别优化:

系统级瓶颈优化:

磁盘读写(SSD / HDD);

磁盘寻道性能;

CPU 频率;

内存带宽;

还有注意平衡可扩展性和性能:

例如使用了 MySQL Dialect 特有的 SQL 语句,就应该注释标明。

5.1 索引

5.1.1 Overview

在 SQL 中,索引就是适当地排序数据,以加快搜索的速度。并且,索引是按照列(数据项)来建立的。

建立索引可以对不是 UNIQUE 的列。

MySQL 中,索引也是一个文件,如果是基于 B+ 树的引擎,那么一个索引的 block 中可能含有若干个树的结点。例如,B+ 树的 1 个结点放一个 block 中,那么读一个结点可以排除结点分叉数量的分支数,大大增大了查找速度。

有一些情况下不适合使用索引,比如从本身的性质上说,可能有如下问题:

索引改善检索操作的性能,但降低了数据插入、修改和删除的性能。因为在执行这些操作时,DBMS 必须动态地更新索引;

在数据源上插入、删除、更新数据,会导致对应的 B+ 树索引出现变动,例如结点分裂、合并等行为。

并非所有数据都适合做索引。

取值不多的数据(如州)不如具有更多可能值的数据(如姓或名),能通过索引得到那么多的好处;

较小的表维护索引带来的代价甚至大于直接 scan 这个表;

索引数据可能要占用大量的存储空间(排序结果需要存起来);

B+ 树本身有较大的空间开销,数据量小的情况下,甚至浪费了空间。

适用索引的场景:

数据过滤和数据排序。如果你经常以某种特定的顺序排序数据,则该数据可能适合做索引;

经常按某列为标识查找数据;

索引还需要管理员定期检查。索引的效率随表数据的增加或改变而变化。许多数据库管理员发现,过去创建的某个理想的索引经过几个月的数据处理后可能变得不再理想了。最好定期检查索引,并根据需要对索引进行调整。

5.1.2 Implementations

其实 MySQL 中不仅可以用 B/B+ 树来实现普通索引。例如:

稀疏索引:R-trees 查询 key 范围的索引;

Hash 索引:Memory tables(视图等内存中的数据结构)支持 hash indexes;

倒排索引:InnoDB 在 Full-text indexes 中采用 inverted lists(倒排索引表);

聚簇索引(cluster index):索引的顺序和数据存储的顺序完全一致的索引

5.1.3 MySQL 何时会使用索引

快速查找与 WHERE 子句匹配的记录;

如果表有多列索引,query plan 可以使用索引最左侧的任何前缀查找记录;

用 JOIN 从其他表中检索记录;

查找特定索引列

key_col的MIN()或MAX()值;对表进行排序或分组,如果排序或分组是根据可用索引的 leftmost prefix 进行的(例如,

ORDER BY key_part1, key_part2);在某些情况下,可以对查询进行优化,以便在不查阅数据行的情况下检索值;

5.1.4 列索引优化

前缀索引

使用 index prefixes 在建立索引时更快。并且越短越好,因为一个 block 中可以盛放更多的记录。

可以只对一个列的前

xxxxxxxxxxCREATE TABLE test (blob_col BLOB, INDEX(blob_col(10)))对于索引前缀的长度:

对于使用 REDUNDANT 或 COMPACT 行格式的 InnoDB 表,前缀长度最多可达 767 字节。对于使用动态或压缩行格式的 InnoDB 表,前缀长度限制为 3072 字节。对于 MyISAM 表,前缀长度限制为 1000 字节。

如果搜索词超过了索引前缀长度,索引将用于排除不匹配的行,并检查剩余行是否可能匹配。

聚簇索引

索引的顺序和数据存储的顺序完全一致的数据存储方式叫做聚簇索引(又称 “主键索引”)。在 InnoDB 中,如果采用聚簇索引,那么表数据文件本身就是按 B+Tree 组织的一个索引结构,而且是以每张表的主键构造一颗 B+ 树,同时叶子节点中存放的就是表的行记录数据,也将聚集索引的叶子节点称为数据页。

作为 InnoDB Table 的存储结构,只要有主键哪怕不建索引也是有一个主键索引。

相对的是次级索引(secondary index,或 “辅助键索引”),一般是用户建表时指定的非主键的索引。这种索引建立的新 B+ 树,叶结点只放这个索引的键(列)以及对应的主键。所以查询时需要拿着主键二次查询才能找到记录,这就是 “次级索引” 名字的由来。

聚簇索引性能好的原因是顺序读。

因为索引记录的位置和存储的位置在顺序上是一样的,这样方便查找和读取。并且聚簇索引尤其适合按主键范围查找。例如:某个节点有多个子节点,从第一个节点到最后一个节点排出来顺序是依次递增的时候,这样显然在查找一个范围的时候就非常快,可以按照顺序来读取磁盘。

聚簇索引的缺点是,

聚簇索引的更新代价比较高,如果更新了行的聚簇索引列,就需要将数据移动到相应的位置。并且,在插入新记录或者更新时如果页满了,可能导致 “页分裂” 的问题;

插入速度严重依赖于插入顺序,按照主键进行插入的速度是加载数据到 InnoDB 中的最快方式。如果不是按照主键插入,最好在加载完成后使用

OPTIMIZE TABLE命令重新组织一下表;聚簇索引可能导致全表扫描速度变慢,因为可能需要加载物理上相隔较远的页到内存中(需要耗时的磁盘寻道操作)。

全文索引

MySQL 也支持全文索引的索引。MySQL 的 InnoDB 和 MyISAM 都支持针对 Char/Varchar/Text 列的索引。

只有当 entire column 和 column prefix indexing 不支持时才会使用。

MySQL 还针对单个 InnoDB 表的某些类型的 FULLTEXT 查询进行了优化。具有以下特征的查询尤其高效:

只返回文档 ID 或文档 ID 和搜索排名的 FULLTEXT 查询;

按得分降序排序匹配行并应用 LIMIT 子句取前 N 条匹配行的 FULLTEXT 查询;

FULLTEXT 查询只检索与搜索词匹配的行的

COUNT(*)值,不需要其他 WHERE 子句。将 WHERE 子句编码为WHERE MATCH(text) AGAINST ('other_text'), 不加任何> 0比较操作符;

稀疏索引 (Sparse Index)

稀疏索引是相对于密集索引而言的,我们前面讨论的索引都是密集索引。

密集索引和稀疏索引的区分在与是否为每个索引键的值都建立索引,简单来说就是比如有一列的值 1、2、3、4、5、6、7,密集索引的做法是为这 7 个值都建立索引记录,那么就有 7 条索引记录;

而稀疏索引的做法是将这个 7 个值分组,1、2、3 和 4、5、6 和 7 分为不同的 3 组,取这三组中最小的索引键值作为索引记录中的索引值。

这两种索引都要通过剪枝来确定数据位置,不同的是密集索引,只需要找到叶结点就能确定准确的数据位置,而稀疏索引则需要先定位到目标结点后,从起始位置继续查找,以此定位具体的偏移量。

这两种不同的索引实现,一种建立了索引值与数据位置的 1:1 的关系,一种建立了索引值与数据位置 1:n 的关系。在大多数场景密集索引查询效率更高,在大多数场景稀疏索引占用空间更小。

总结与密集索引相比的优点:

节省存储空间,因为索引条目较少;

适用于顺序扫描和范围查询。

缺点:对于精确查找的效率较低,因为需要扫描更多的数据块。

空间索引 (Spatial Index)

对于空间索引,MySQL 的 InnoDB 和 MyISAM 引擎都支持 R-Tree 数据结构来存放索引。

那么什么时候会用 R-Tree 来建立空间索引呢?答案是碰到高维数据的时候。举个例子:

xxxxxxxxxx-- MySQL SPATIAL INDEX 会使用 R 树来索引 coordinates 列,从而加速空间查询CREATE TABLE locations ( id INT PRIMARY KEY, name VARCHAR(100), coordinates POINT, SPATIAL INDEX(coordinates));从这个例子注意到,空间索引对高维数据的临近查询比较友好。

多列索引(复合索引)

对使用多列的索引,MySQL 支持组合索引(composite indexes)。例如:

一个索引可以包括最多 16 个列;

对于某种 data type,可以按照组合索引只索引前几个 column;

多列索引的优势:

建立三个单独的索引比建立一个复合的索引要浪费空间,B+树的叶子节点存储要索引的值还有一个指向 硬盘的位置,而建立三个单独的索引,就需要三个树,叶子结点存储的同理,也就是说建立复合索引相 对来说更好。而且调整一棵树的速度比调整三棵树的效率显然要快的;

哪些查询 pattern 适合使用 multiple-column indexing?

涉及所有列的 queries;

涉及前 N 个列的 queries;

例如这么建索引:

xxxxxxxxxxCREATE TABLE test ( id INT NOT NULL, last_name CHAR(30) NOT NULL, first_name CHAR(30) NOT NULL, PRIMARY KEY (id), INDEX name (last_name,first_name));这种查询就能用上(只有一定先判断 last_name 再 first_name):

xxxxxxxxxxSELECT * FROM test WHERE last_name='Jones'; SELECT * FROM test WHERE last_name='Jones' AND first_name='John'; SELECT * FROM test WHERE last_name='Jones' AND (first_name='John' OR first_name='Jon'); SELECT * FROM test WHERE last_name='Jones' AND first_name >='M' AND first_name < 'N';而这种查询就没法用上:

xxxxxxxxxxSELECT * FROM test WHERE first_name='John';SELECT * FROM test WHERE last_name='Jones' OR first_name='John';也就是必须是 leftmost prefix of the indexes;

值得注意的是,即便某次查找用上了复合索引,也不代表对每一列的筛选条件都能真正利用这个索引。这很抽象,我们用一个案例解释一下:

假设数据库中一个表包含:{ a: int(PK); b: int(PK); c: int };

然后 MySQL 对两个主键自动建立复合索引,我们记为 PRIMARY_IDX;

我们手动对 b, c 建立复合索引(b 先 c 后),记为 NEW_IDX,我们讨论:

当筛选条件使用

a = 10 AND b = 7 AND c > 1时:两个复合索引

PRIMARY_IDX和NEW_IDX都是可用的;EXPLAIN可以看到使用到的索引键长度(key_len)为 8;因为这里直接使用a, b的联合主键索引能找到唯一记录,c > 1仅作为筛选条件,不再使用索引;

当筛选条件使用

a = 10 AND b > 7 AND c > 1时:两个复合索引都是可用的(对两个索引来说都是按顺序的 leftmost prefix);

EXPLAIN可以看到使用到的索引键长度为 8;因为这里使用a = 10和b > 7,两个列的复合索引键长为数据结构的长度和;已经可以确定记录集合(获得的结果不再是 B+ 树结果),再通过c > 1的筛选,没有再使用索引了;

当筛选条件使用

b = 7 AND c > 1时:只有

NEW_IDX是可用的;EXPLAIN可以看到使用到 d 的索引键长度为 8;此时使用b, c复合索引(另一棵 B+ 树);

当筛选条件使用

b > 7 AND c > 1时:只有

NEW_IDX是可用的;EXPLAIN可以看到使用到的索引键长度为 4;这时虽然用了b, c联合主键,但是只能对第一个出现的范围查找索引生效。主要是因为范围查找后不再是一个 B+ 树,而是一个 B+ 树集合,再对每个 B+ 树中筛选c > 1就没法利用索引了,只能顺序扫描遍历,因此只用到复合索引中的一列而已。

内存索引

MySQL 默认使用 Hash Indexes,不过也支持 B-Tree;

Hash 索引

比较一下 Hash Indexes 和普通 B+ 数索引的异同:

B-Tree Indexes 可以在对一列使用

=, >, >=, <, <=, BETWEEN这些操作符,以及不含 wildcard / 其他列 的LIKE操作符;Hash Indexes 主要用于判等性(单值)的 operators 例如

=, <>,远远快于 B-Tree Indexes。因此像 KVStore 这样的系统都依赖于这种索引。但是有以下问题:其他的范围性操作符均不支持,如

<;不支持顺序。不能用于加速

ORDER BY操作;

降序索引

指定让索引存储的键值降序摆放(因为有建索引后 ORDER BY XXX DESC 的需求,不用 descending indexes 会造成性能 penalty);

倒序索引还可以支持 multiple-column indexes 的混合升降序的优化(表事先定义一些索引方法);

5.2 主键优化

有几条策略:

当没有明显主键可以选择时,用自增主键;

在 InnoDB 中,主键的查询、排序的性能会相当地好;

如果使用随机生成的值作为 primary Key,也尽量前缀一个类似时间戳的递增的成分(如果允许的话);

一是考虑 InnoDB 聚簇索引的性质;

二是因为连续递增的 primary key 在 B+ 树上相邻,获取时顺序读,而且可以利用空间局部性,降低 disk I/O;

另外,有一种热门的问题,“究竟选 Java UUID 还是自增主键?哪个更好?”

这里涉及 UUID 和自增主键的选取问题。

UUID 的优势:

全局唯一性:通过不同算法生成,几乎能够保证在全球范围内的唯一性,从而避免了多台机器之间可能发生的主键冲突问题。

不可预测性:随机生成的 UUID 很难被猜测,因此在需要保密性的应用场景下非常适用。

分布式应用:由于可以在不同的机器上生成 UUID,因此可以被广泛应用于分布式系统中。

存储空间较大:UUID 通常以字符串形式存储,占用的存储空间较大。

UUID 的劣势:

不适合范围查询:由于不是自增的,不支持范围查询。新生成的 UUID 可能会插入到已有数据的中间位置,导致范围查询时出现数据重复或漏数据的情况。

不方便展示:UUID 通常比较长,且没有明确的业务含义,因此不太适合在系统间或前台页面进行展示。

查询效率低下:

在 UUID 列上创建索引会导致索引大小增加,从而影响缓存命中率,增加磁盘 I/O 需求,同时也增加了查询时的内存开销。

当使用 UUID 进行排序时,新生成的 UUID 通常会插入到叶子节点的中间位置,导致 B+树的频繁分裂和平衡操作,进而影响查询性能。

自增主键的优势:

存储空间节省:ID 为数字,占用的位数比 UUID 小得多,因此在存储空间上更加节省。

查询效率高:ID 递增,利于 B+Tree 索引的查询效率提高。

方便展示:ID 较短,方便在系统间或前台页面进行展示。

分页方便:ID 连续自增,有利于解决深度分页问题。

自增主键的劣势:

分库分表困难:在分库分表时,无法依赖单一表的自增主键,可能导致冲突问题。

可预测性:由于 ID 是顺序自增的,因此具有一定可预测性,存在一定的安全风险。

可能用尽:自增 ID 可能是 int、bigint 等,但它们都有范围限制,可能会用尽。

性能问题:在数据迁移期间,如果使用自增主键,数据库可能会产生额外的性能开销。这可能是由于重新计算主键值或更新相关索引所致。这可能会导致数据迁移过程变慢。

5.3 外键优化

如果一个表有很多列,而您要查询的列有很多不同的组合,那么将不常用的数据分割成单独的表,每个表只有几列,并通过复制主表中的数字 ID 列将它们与主表关联起来,可能会比较有效。

这样,每个小表都可以有一个主键,以便快速查找数据,而且可以使用 JOIN 操作只查询所需的列集。

根据数据的分布情况,查询可能会执行较少的 I/O,占用较少的缓存内存,因为相关列都集中在磁盘上。(为了最大限度地提高性能,查询会尽量少从磁盘读取数据块;只有几列的表可以在每个数据块中容纳更多行)。

5.4 数据库结构优化

Look for the most efficient way to organize your schemas, tables, and columns.

Minimize I/O, keep related items together, and plan ahead so that performance stays high as the data volume increases.

这首先从设计好的数据库开始,能让团队写出更高性能的代码,并让数据库可以承受 application 的迭代和修改的需求。

5.4.1 数据大小

从数据大小的角度,尽可能减小 table 在磁盘上占用大小。这能影响到一个事件内磁盘 I/O 的总体效率,并且总体内存占用少、索引占用也少。

优化 Table Columns:尽可能使用最小、最精简有效的类型。例如对于小一点的整型,使用

MEDIUMINT比INT节省 25% 空间;尽可能使用 NOT NULL:

在《高性能 MySQL》中指出,可 NULL 列需要额外的空间来说明这个值是否为 NULL(在 MyISAM 引擎中一列 1 bit);

难以优化引用可空列查询,它会使索引、索引统计和值更加复杂(需要在读取时测试一些值是否为 NULL),降低效率;

容易自己写出错误,即

NOT IN、!=等负向条件查询在有 NULL 值的情况下返回永远为空结果;

如果语义上实在需要 NULL,可以保留。只是要避免默认全是可空的情况。

优化行格式:创建表时指定合适的 row format;

COMPACT、DYNAMIC、COMPRESSED 这些方式通过牺牲 CPU 在某些操作上的性能换取更低的存储开销;

例如使用一些 variable-length character set(utf8mb3/4 之类的)时,可以降低

CHAR类型列的存储开销;会通过 stripping trailing spaces 的方式减小存储开销;

REDUNDANT:意味着

CHAR(N)就会占用N倍的 charset 大小;许多程序是用 single-byte utf8 characters 来写,所以这种配置大部分情况下都是浪费空间;

FIXED:每列固定长度,在一些场景下能加速查找或其他操作的性能,但可能造成一些空间浪费;

if you do not have any variable-length columns (VARCHAR, TEXT, or BLOB columns);

you want to have fixed length rows even if you have VARCHAR columns;

优化索引:设计表时建立合适的索引;

尽量少地创建索引,只对能提升查询性能的列索引。虽然索引提取很简单,但是维护会损耗插入和更新操作的性能。并且不是所有情况都适合;

如果经常组合特定的列查询,则对这些列建组合索引,而不是分别索引;

主键索引应该越短越好。这样:区分每一列的速度更快、block 存放更多更易 cache;并且在 InnoDB 表中 primary key columns 会在 secondary index entry 中重复,所以为了整体的存储效率应该短一点;

注意到 UUID 和 自增主键的选取中也提到此条。

一个比较长的字符串列,更有可能有 unique prefix。因此仅对这些列的 prefix 索引(参见 “前缀索引”),好处包括但不仅限于检查更快、更容易 cache;

优化 JOIN 操作:决定是否放在一个表,还是分两个表,需要时再 JOIN;

在某些情形下(例如 dynamic-format table 中)分成两个表(smaller static format)搜索速度更快;

在需要 JOIN 的表中尽量用一个相同信息和类型的列(如外键),方便 JOIN 操作;

尽量将列名起得简练一些(考虑到兼容性、SQL JOIN 查询便捷性);

标准化:

考虑遵循第三范式,减少数据冗余性;

如果性能比空间、维护多份重复数据的开销更重要,则可以适当放宽范式条件;

5.4.2 MySQL 数据类型

针对数值类型数据优化:当数值和字符串都能描述数据时,优先数值。因为它的存储效率更高,传输、处理和比较成本更低;

针对字符/字符串型数据优化:

选择 binary collation order(二进制规则顺序),能加快比较、排序的速度;

query 比较不同 columns 时,尽量避免字符串;如果不能,也要保证使用的是同一个 character set 和 collation;

对于小于 8KB 数据,应使用 Binary Varchar 而不是 BLOB;

因为如果表没有 BLOB 类型的 column,GROUP BY 和 ORDER BY 子句可以生成临时表格,并利用 memory engine 加速;

如果一个表的 string column 不经常被查询,考虑将它们拆分出另一个表,并且必要时 JOIN;

因为可以提升每个 block 的记录数量,提升 cache 数量,减小 disk I/O 次数。并且定长 row 利于查找优化;

针对 BLOB 类型优化:

包含大量 textural content 的 BLOB 首先需要压缩;

考虑将 BLOB 分出另外一个表,甚至分到其他存储设备上,来降低单条记录的查询成本;

比起在 query 中直接比较很长文本的相等性,应该计算 hash 存在单独一列中用于比较;

5.5 数据库多表优化

5.5.1 MySQL 如何管理 Open/Close Tables

对于数据库中的很多表而言,MySQL 需要对这些表进行管理,让不同的 client(connections)都能获得比较快的速度。

有一种方案是和 OS 的 File 一样,在内存中管理 File Descriptor 和 Open File Table,后者可以在所有进程间复用。

在 MySQL 中,每个表可能在不同的 connections 中都打开过,因此当你执行 mysqladmin status 发现 open tables 数量多于实际表数时也不要疑惑。

由于 MySQL 是多线程程序,为了让多个 client 访问的 table 不至于冲突(尤其是事务冲突),会有 锁 和 MVCC 来管理修改操作。其中对每一个 session 而言都有一个独立的 open table,以防止数据依赖,达到空间换时间的效果。

对于 MyISAM 引擎的表来说,每个打开的数据文件还需要多存一个 file descriptor。

我们一般通过配置信息来影响数据库效率:

table_open_cache:与max_connections有关。如果max_connections = 100,则最多与 100 个 client 建立连接,按一个连接中任意查询中最多关联到的表的个数N来计算,应该设置table_open_cache = 100 * N,还要考虑到为临时表以及文件(Internal Temporary Table / Files)预留一些 file descriptors;具体什么时候产生临时表/临时文件,请参考官方文档 Internal Temporary Tables - Oracle;

以上二者同时影响 server 最大能打开的文件数。设置过大超过 OS 处理能力或者 file descriptor 限额,会导致性能下降、不稳定甚至错误(refusing connections or failing to perform queries);

MySQL 会在如下场合关闭 opened table(必要时写回):

evict:cache 满了,但是 client 尝试打开一个不在 cache 中的表;

full 情况下的 evict 策略:

对没有线程使用的表,采取 LRU 抛弃策略;

如果所有表都被使用中,则临时扩大一下 cache(由 “too many idle tables” 策略回收);

too many idle tables:cache 中包含超过

table_open_cache数量的表,并且该表没有被任何线程使用;flush tables:当 FLUSH 操作进行时;

由上面的策略,我们可以侧面看出,如果 MySQL 的 table_open_cache 设置偏少,会出现以下现象(可以作为检查的方案):

检查 Open tables 数据非常大(远大于设定值),并且从数据库刚启动时就快速增长,而此时 FLUSH 操作并不多。

同时,MyISAM 这样保留 open tables 还是有弊端的。主要是拿空间换时间,而且可能过犹不及。

Disadvantages:

open tables 过多的话,打开、关闭、创建操作性能下降;

select 如果同时关联很多表,则没法很好地利用空间局部性(主要是 workspace 不够大,会频繁 cache evict);

5.5.2 数据库数量限制调优

数据库/数据库表的数量

MySQL 默认不限制数据库和数据库表的数量。

数据库的物理上限为底层文件系统的最大目录数(for databases);

数据库表的极限除了受到文件系统的 “文件(for tables)数量限制”,还受存储引擎自身限制。如 InnoDB 最多支持 40 亿张表;

数据库表的大小

MySQL 最大表大小默认不限制,取决于文件系统单个文件大小。

一旦出现达到表最大大小的情况,MySQL 会抛出 full-table error,主要原因如下:

磁盘可能满了;

达到底层文件系统的单个文件大小上限;

例如 Windows 系统上的 FAT/vFAT 文件系统最大支持 4GB 文件,这种文件系统显然不适合用于运行大型 MySQL 数据库;

如果使用的是 MyISAM 存储引擎,则可能是超过了 internal pointer size 默认允许的空间(256 TB);

回想一下 MyISAM 的主键索引使用的是指针;

MyISAM 引擎允许数据和索引文件最大 256 TB,当然可以人为设置这个限制,限制的上限是 65536 TB;

如果使用的是 InnoDB 存储引擎,则可能是表对应的 tablespace file 达到大小极限了;

Tablespace File 是 InnoDB 中用于管理一个或多个数据表以及相关的索引的数据的文件。

根据配置主要有 3 类:System tablespace、File per tablespace、General tablespace;

包括但不仅限于:

InnoDB data dictionary.

DoubleWrite Buffer.

Change buffer

Undo Logs.

以及表本身数据、索引数据。

可以通过分多个 tablespace files 解决这个问题。官方只建议在大于 1 TB 的情况时再考虑;

数据库表的列数和行的大小

MySQL 硬编码表的列数限制:一个表中不得超过 4096 个列。InnoDB 表额外限制不允许超过 1017 个列。

最终,最大表列数应该取决于:

最大的行数(限制了列的数量和大小);

Functional Keys:使用隐藏的虚拟生成列实现,因此也要考虑它的大小;

值得注意的是,表的最大行大小不取决于表的最大大小!

哪怕存储引擎能够放的下更大的行大小,实际上 MySQL 也限制了表的最大行的总大小为 65535 bytes;

注:其中 BLOB 和 TEXT 这种大数据类型,MySQL 直接使用指针存储(指针指向另一个文件中,专门用于存储此类数据)。

因此 BLOB 和 TEXT 总是仅占用一行 9~12 bytes 的大小。

在这个前提基础上,还有一些规则会影响实际使用中的表的最大行的大小:

对于 InnoDB 引擎,存储在本地 database page 中的表,其最大大小略小于 page size 的一半;

注:可以通过设置

innodb_page_size来设置一个 page 的大小;不同的 storage format 使用不同大小的 page header 和 trailer data,也会影响最大行大小。

举例说明:

xxxxxxxxxxCREATE TABLE t (a VARCHAR(10000), b VARCHAR(10000), c VARCHAR(10000), d VARCHAR(10000), e VARCHAR(10000), f VARCHAR(10000), g VARCHAR(6000)) ENGINE=InnoDB CHARACTER SET latin1; 上面这个表默认 row format 是 dynamic 的,一行长度为 66000 bytes,超过限制,因此无法创建成功;

下面这个表用 MyISAM 引擎也是一样不允许(MySQL 规定)。

xxxxxxxxxxCREATE TABLE t (a VARCHAR(10000), b VARCHAR(10000), c VARCHAR(10000), d VARCHAR(10000), e VARCHAR(10000), f VARCHAR(10000), g VARCHAR(6000)) ENGINE=MyISAM CHARACTER SET latin1;由于 BLOB 和 TEXT 采用指针存储,因此这么定义又没问题(InnoDB 同理):

xxxxxxxxxxCREATE TABLE t (a VARCHAR(10000), b VARCHAR(10000), c VARCHAR(10000), d VARCHAR(10000), e VARCHAR(10000), f VARCHAR(10000), g TEXT(6000)) ENGINE=MyISAM CHARACTER SET latin1;还需要注意,NOT NULL 这类限定词也会占用一行中的空间(通常是每个字段 1 byte)。

这种不行:

xxxxxxxxxxCREATE TABLE t2 (c1 VARCHAR(65535) NOT NULL) ENGINE = InnoDB CHARACTER SET latin1; 但这种(65533)可以:

xxxxxxxxxxCREATE TABLE t1 (c1 VARCHAR(32765) NOT NULL, c2 VARCHAR(32766) NOT NULL) ENGINE = InnoDB CHARACTER SET latin1;

5.6 InnoDB 表优化

5.6.1 InnoDB 存储效率优化

MySQL 支持使用

OPTIMIZE TABLE <table>优化较大的表,来 reorganize、compact 碎片化的空间;这个步骤的原理是,将数据从原表中 copy 出来,并且重建索引,减小 tablespace 中的 inner fragementation。

和主键优化一样,如果主键较长,可能导致构建索引时浪费空间;

如果是 long 数据,则可以考虑自增主键;

如果是 varchar 数据,则可以考虑前缀索引;

建议就使用

VARCHAR来存储长度可变的字符串,而不是CHAR,因为后者存在内部碎片(尤其是存在 NULL 的情况)。只有明确这个数据有固定的长度(例如学号始终只有 11 位)时才使用CHAR;如果表很大,并且含有大量重复的字符串、数值接近或重复的数值数据类型,那么考虑使用

COMPRESSEDrow format。但是注意是读写性能换空间;只有当空间很大,需要牺牲性能来节省空间时,才选择

COMPRESSED行格式;

5.6.2 InnoDB 事务优化

MySQL 默认

AUTOCOMMIT=1,意味着即便是每条普通的 SQL 也会创建一个单独的事务并提交(哪怕只读),这可能在一个繁忙的数据库中形成性能瓶颈;如果需要配置的话,可以 CLI 或建库脚本中

SET AUTOCOMMIT = 0;手动管理、人为划分事务边界。即便使用

AUTOCOMMIT,实际上 InnoDB 可能针对简单的只读(SELECT)事务,会进行一些优化;

避免在 插入/删除/更新 大量表记录 后执行 rollback;

如果需要回滚一个大的事务(尤其是发现一个大事务很卡,准备手动 rollback 它),意味着要重新读并执行 undo log,可能需要消耗比它本身耗时更长的时间来完成,恶化数据库的性能;

而且直接 kill 是没有用的,因为重启后还会恢复 undo/redo;

因此,一个大的事务本身就不合适,需要拆成若干适当大小的事务;

避免使用长期的事务(例如一次执行 2 h);

因为在 READ COMMITTED 或 REPEATABLE READ 中,两个事务可能操作了更多的相同记录的数据,就需要锁/MVCC 做更多的事情(例如读旧的值、更新值),进一步影响性能;

长期的含写事务会导致接下来的事务没法利用 Covering Index 来加速查询;

注:所谓 Covering Index,就是说不必查询表文件,单靠查询索引文件即可完成。它不是一个专门的索引数据结构,而是查询请求和当前索引匹配的现象。覆盖索引的好处,一是辅助索引不包含整行记录的所有信息,故其大小要远小于聚集索引,因此可以减少大量的 IO 操作;二是不必回表;

但是 Covering Index 不能在有修改操作的事务正在执行时使用,因为修改过程中需要重构索引。

适当增大 buffer pool 大小(参见下文),可以减少写磁盘的频率,减小 disk I/O;

设置

innodb_change_buffering=all,减少更新删除的刷盘次数;

对于 InnoDB 只读事务优化(InnoDB 自动对这些只读事务优化,我们只需要知道如何让 InnoDB 知道就行):

使用

START TRANSACTION READ ONLY开始的事务;开启了

AUTOCOMMIT并且是一条单独SELECT语句;

因此能作为只读事务时,就标记

READ ONLY,以方便优化。

5.6.3 InnoDB 载入大量数据时优化

建议关闭

AUTOCOMMIT,因为不然每次执行后都会 commit 并且进行 log flush;xxxxxxxxxxSET autocommit=0;-- ... SQL import statements ...COMMIT;如果表中有次级索引的键被

UNIQUE修饰,可以考虑关闭 uniqueness checks(SET unique_checks=0;),最后再打开。但是需要确保确实没有重复的键;因为 MySQL 可以将修改写入 change buffer 并批量写,而不需要频繁的 disk I/O;

同样地,如果确定确保了插入数据的外键关联,也可以关闭外键检查:

SET foreign_key_checks=0;(通用)使用 multi-row

INSERT语法,能降低通信开销;xxxxxxxxxxINSERT INTO yourtable VALUES (1,2), (5,5), ...;如果向有自增主键的表导入数据,可以考虑设置

innodb_autoinc_lock_mode为 2(interleaved)而不是 1(consecutive);

5.6.4 InnoDB 查询优化

和主键优化一样,对最重要、查询热点的、时间关键路径上的列设定主键;

和主键优化一样,不用选一个很长的列作索引;

不要对太多列建立次级索引(secondary index),因为一次查询最多只能用到一个;

和 组合索引 一样,建议用到多个时组合索引,而不是各自建立索引;

和 “数据大小” 的优化一样,建表时尽量使用 NOT NULL;

InnoDB 内部也会对单个只读查询的事务优化,见前文。

5.6.5 InnoDB Disk I/O 优化

注意:不应该首先考虑对 InnoDB 的 disk I/O 优化。当你很好地遵循了数据库设计原则、tuning operations 后,性能瓶颈仍然在 disk I/O,例如性能很慢但 CPU 占用小于 70%,可以再考虑下面的优化:

适当提升 buffer pool 的大小:设置

innodb_buffer_pool_size,减小对硬盘读写次数;调整刷盘方法:设置

innodb_flush_method为O_DSYNC来延迟刷盘;配置刷盘阈值(fsync):设置

innodb_fsync_threshold。例如当多个 MySQL 使用同一存储设备时减小这个阈值可能提升性能;考虑选择固态,而不是机械磁盘(rotational storage)来增大随机写速率;

如果 MySQL 的吞吐量因为 InnoDB 事务的 checkpoint 而周期性降低,考虑增大

innodb_io_capacity(提升刷盘频率,avoiding the backlog of work that can cause dips in throughput);

5.6.6 InnoDB DDL 操作优化

使用

TRUNCATE TABLE而不是DELETE FROM *,因为后者还是需要一条条删除;如果有外键关联,可能 truncate 也不快,这个时候考虑先 drop 再 create;

由于 InnoDB 使用了聚簇索引,修改主键可能造成大量的重建操作。因此设计主键时就要避免修改操作;

5.7 MEMORY 表优化

对于不重要的、经常访问的、只读的、很少更新的数据,考虑存放在 MEMORY 表(

ENGINE=MEMORY);Memory 表使用和 MyISAM 一样的锁机制,因此在有读有写的场景下的性能甚至比不上 InnoDB;

另外,如果数据大小超过 Buffer Pool,还会发生换入换出,进一步降低性能;

根据经常查询的 pattern(单独判等还是范围查找)来选择合适的索引(B-Tree Index / Hash Index);在创建索引时,可以指定

USING BTREE或USING HASH;

5.8 Buffering and Caching

InnoDB 维护了一个称为 “buffer pool” 的存储区域,来在内存中缓存数据和索引。

InnoDB 在管理 buffer pool 的策略上使用了 LRU Algorithm,确保热点数据驻留在内存中:

新加入的 page 放在 LRU list 尾部

后

在严格的 LRU 配置下这些总不被访问的数据会被 “age out”,或者作为 cache evict 的首选对象;

对 InnoDB Buffer Pool 进行优化:

设置

innodb_buffer_pool_size(操作总是以 chunck 为单位);buffer chunck 大小

innodb_buffer_pool_chunk_size默认 128 MB。Buffer Pool 的大小总是需要满足:

innodb_buffer_pool_chunk_size * innodb_buffer_pool_instances的整数倍;使用多个 buffer pool 实例(提升并发性能):设置

innodb_buffer_pool_instances;同样注意 buffer pool size 满足的整数倍关系,最好确保每个 pool 实例大小 1 GB;

默认 1,最大 64。pool size 总大小不足 1 GB 时该项无效;

设置 buffer pool 的预取(prefetch):根据程序的局部性原理,InnoDB 会异步作 page 预取(read-ahead),主要有两种形式:

Linear read-ahead:顺序预取(预取下一个相邻页);

Random read-ahead:根据 pool 中已有的的 page,在合适的 cadidates 中随机选取;

您可以

SHOW ENGINE INNODB STATUS检查 read ahead 的有效性,并且 tuninginnodb_random_read_ahead;设置 buffer pool 的 flushing 策略:

在 MySQL 8.0 中,buffer pool 的 flushing 工作交给 page cleaner threads 完成;

线程数量由

innodb_page_cleaners控制(默认为 4)。当 threads 数量少于 pool instances 数量时,自动设置 threads 数量与其相等;flushing 的阈值由

innodb_max_dirty_pages_pct_lwm控制,当 dirty page 比例超过阈值时 flush(默认 10%;0 表示禁用 early flushing);

buffer pool 的备份和恢复策略:

为了加速启动时 buffer pool cache 的 warmup 过程,InnoDB 在关闭前事先保存一些热点 page 并在启动时恢复。可以通过 tuning

innodb_buffer_pool_dump_pct来获得更好的性能;

Chapter 6. 数据库备份与恢复

回忆为什么需要备份数据库?

预防错误:system crashes (系统错误), hardware failures (硬件错误), or users deleting data by mistake (人为错误).

准备升级:as a safeguard before upgrading a MySQL installation;

准备从节点:为 replicas 创建提供原数据;

这些是我们之前提到的 Fault Recovery Mechanism(redo/undo)解决不了的。

如何备份?

逻辑备份 / 物理备份?全量备份 / 增量备份?

如何创建备份格式?(SQL/CSV 等等)

恢复方法如何?

备份时是否做调度(深夜进行?)、是否压缩、是否加密?

能否从被破坏的表中恢复出来?

6.1 备份和恢复的类型

物理备份:consist of raw copies of the directories and files that store database contents.

This type of backup is suitable for large, important databases that need to be recovered quickly when problems occur.

优点:速度快、备份和恢复简单;

缺点:不能改动数据库引擎,甚至小版本都需要一致;

适用场景:数据量极大的场景;

逻辑备份:save information represented as logical database structure (CREATE DATABASE, CREATE TABLE statements) and content (INSERT statements or delimited-text files).

This type of backup is suitable for smaller amounts of data where you might edit the data values or table structure, or recreate the data on a different machine architecture.

优点:只需要关系型数据库,大部分都可以转移;

缺点:备份和恢复的速度较慢、备份文件的存储效率不高;

适用场景:数据量不大的场景;

在线备份:take place while the MySQL server is running so that the database information can be obtained from the server.

优势:对用户、业务影响小,可用性好;

缺点:但是需要有复杂的、恰当的锁机制来确保数据一致性(The MySQL Enterprise Backup product does such locking automatically);

离线备份:take place while the server is stopped.

Clients can be affected adversely because the server is unavailable during backup. For that reason, such backups are often taken from a replica that can be taken offline without harming availability.

The backup procedure is simpler because there is no possibility of interference from client activity.

无论是备份时,还是恢复时,都有上述的讨论。

二者差别也被称为 “hot backups vs cold backups”;

Note

折中方案:a “warm” backup is one where the server remains running but locked against modifying data while you access database files externally(server 正在运行,但只允许读操作).

补充:

Customers of MySQL Enterprise Edition can use the MySQL Enterprise Backup product to do physical backups of entire instances or selected databases, tables, or both.

This product includes features for incremental and compressed backups.

And InnoDB tables are copied using a hot backup mechanism.

(Ideally, the InnoDB tables should represent a substantial majority of the data.)

Tables from other storage engines are copied using a warm backup mechanism.

本地备份:备份操作机器和 server 运行的机器是同一台;

远程备份:与本地备份相反,备份操作的机器和 server 运行的机器不是同一台(例如远程的 mysqldump);

但是:

使用

mysqldump的 SQL output(逻辑备份)存放在调用的 client 侧,Delimited-Text output(文本形式)存放在 server 侧;大多数情况下物理备份放在 server 侧;

快照备份(snapshot backup):使用特殊的文件系统,允许使用 logical copy(Copy On Write 延迟复制);

MySQL 自己不支持对文件系统快照,需要使用第三方解决方案。

全量备份:includes all data managed by a MySQL server at a given point in time.

增量备份:consists of the changes made to the data during a given time span (from one point in time to another).

通过 enable server 的 binary log(bin log)来让 MySQL 记录 data changes;

备份调度:对自动化备份至关重要;

备份压缩:减小备份带来的空间开销;

备份加密:提升对未授权访问 backed-up data 的安全防护;

这三个功能在 MySQL 社区版中都没有。

6.2 实践

使用 mysqldump 进行逻辑备份。对 InnoDB(支持事务)表,可以通过传入 --single-transaction 来实现无需加锁的 online backup.

如果进行物理备份:

如果是 MyISAM 表,需要停止 server / 给表加读锁(read lock 禁止写),然后 flush 对应的表(落盘,让所有 active index pages 写入磁盘),最后复制文件(

*.myd, *.myi, *.sdi);对于 InnoDB 表这么做不行,因为它存在 cache buffer pool,数据也许不会刷盘。这会导致数据不一致性;

如何使用 bin log 完成增量备份?

使用 FLUSH LOG 或 mysqldump --flush-logs 向文件中写入自从上一次备份结束后更改的信息。

使用 SHOW BINARY LOGS 查看当前哪些增量日志文件;

使用 SHOW MASTER STATUS 查看当前正在向哪个增量日志文件写;

使用 mysqlbinlog <binlog> 读未加密的 bin log 内容;

使用 mysqlbinlog --read-from-remote-server --host=host_name --port=3306 --user=root --password --ssl-mode=required binlog_files 读加密的 bin log 内容;

使用主从备份(using replicas):

适用场景:单机备份仍然有性能问题。此时可以考虑建立 replication 做备份;

官方文档说:

如果要备份副本,无论选择哪种备份方法,都应在备份副本数据库时,备份其连接元数据存储库(connection metadata repository)和应用程序元数据存储库。

在恢复副本数据后,总是需要恢复这些元信息。例如如果 replica 正在复制 LOAD DATA 语句,则还应备份目录中存在的任何

SQL_LOAD-*文件。replica 需要这些文件来恢复任何中断的 LOAD DATA 操作。

恢复被破坏的表:

对 MyISAM 表,只需要执行 REPAIR TABLE / myisamchk -r 就能解决 99.9% 的问题;

使用第三方工具做 snapshot 备份,例如 LVM、ZFS;

6.3 备份和恢复的策略

现在我们讨论更多的故障种类中,MySQL 现在可以进行的恢复机制。

对于 事务崩溃 / 系统崩溃 / 掉电,我们假设重启后磁盘没有问题,那么:MySQL 使用 redo log 和 undo log 找到 “已提交未刷盘事务” 重做刷盘、“未提交暂时刷盘事务” 撤销动作;

对于 文件系统崩溃 / 硬件(如磁盘)故障,我们假设重启后数据没法恢复,那么需要 主从备份/异地容灾的机制,并且重新格式化磁盘、安装新的文件系统,看看能否解决问题,并从其他物理结点恢复。

对于第二种情况,MySQL 没法完全帮我们恢复数据,因此我们需要一些策略来主动备份数据。大致的策略可以是 对数据库表周期性自动化备份。举个例子:

在星期天下午 13 点进行一次全量备份:

xxxxxxxxxxmysqldump --all-databases --master-data --single-transaction > backup_sunday_1_PM.sql在执行这个全量备份时,需要对所有 tables 上读锁。

为了方便和性能起见,全量备份虽然必要,但不应该频繁。因此接下来利用增量备份(需要启动时

--log-bin或者通过配置 enable bin log)自动完成;能在数据库目录中看到

*-bin.0000xxx/index的名称格式的文件,它们就是 bin log;为了节省空间,可以时不时清空这些 log(建议放到之前的全量文件中):

xxxxxxxxxxmysqldump --single-transaction --flush-logs --master-data=2 \--all-databases --delete-master-logs > backup_sunday_1_PM.sql假设在星期三早上 8 点,数据库崩溃,那么我们进行下面的恢复过程:

先恢复星期天创建的全量备份:

xxxxxxxxxxmysql < backup_sunday_1_PM.sql现在数据库所有信息全部恢复到星期天下午 13 点的状态(如果期间做过 bin log 删除,那么可能更新一点);

恢复从上次创建全量备份以后的增量备份文件,例如:

xxxxxxxxxxmysqlbinlog gbichot2-bin.000007 gbichot2-bin.000008 | mysql# 不应该使用多个 mysql connections 分别加入,可能会出问题,因为可能第一个文件有 CREATE TEMPORARY TABLE# mysqlbinlog gbichot2-bin.000007 | mysql# mysqlbinlog gbichot2-bin.000008 | mysql如果是硬盘损坏丢失了部分的 bin log,则数据就真的丢了。但如果我们一开始指定的 bin log 使用异地容灾的思想,记录在其他物理节点上,那么数据的丢失就可以避免了。

总结,定期使用全量(mysqldump)和增量(FLUSH LOGS / mysqladmin flush-logs + enable bin log)备份,其中全量备份的频率小一点,并且可以考虑异地容灾。

Chapter 7. 数据库分区

分区不等于分表!

对 MySQL 引擎 InnoDB 和 NDB 都支持分区。

本质上是将表拆成不同粒度的集合,每一块可以单独处理以提升查询速度。

分区的方式被称为 “partitioning function”,可以是用户指定的,也可以内置 hash / 线性 hash、分区列表,等等。

分区方式可以是:

Horiztonal Partitioning:different rows of a table may be assigned to different physical partitions;

到 2024 年为止,MySQL 没有计划支持 Vertical Partitioning;

因为意义不大,真要这么做,不如拆成两张表。

分区的好处:

让一张表中可以放更多数据,不受磁盘和文件系统的限制,成为一种可能。

可以便捷地、高效地清除某个分区中的所有无用数据、添加新数据(尤其是表很大的时候);

因为通常放在不同的地方,用指针管理?

某些查询能借助分区被极大地优化(例如

WHERE选择的都在某个分区内,会由 Query Plan 识别);这被称为 Partition Puring:“cutting away” of unneeded partitions is known as pruning;

MySQL 还支持显式按分区查询,如:

SELECT * FROM t PARTITION (p0,p1) WHERE c < 5;不光

SELECT,修改操作也能受益。显式使用被称为 Partition Selection;

7.1 Types of Partitioning

Horizontal Partitioning 主要可以被分为 4 类:

7.1.1 RANGE Partitioning

RANGE partitioning: 根据记录列在某一范围内的值为依据分区;

举例:

xxxxxxxxxxCREATE TABLE members ( firstname VARCHAR(25) NOT NULL, lastname VARCHAR(25) NOT NULL, username VARCHAR(16) NOT NULL, email VARCHAR(35), joined DATE NOT NULL ) -- 按时间年份范围分区(LESS THEN 中的值还需要升序排列,因为单边限制)-- 为何只支持单边限制?-- 首先考虑用户制定的可能不是连续区域、可能会重叠-- 便于用户修改(例如需要删除一个分区或添加一个分区)PARTITION BY RANGE( YEAR(joined) ) ( PARTITION p0 VALUES LESS THAN (1960), PARTITION p1 VALUES LESS THAN (1970), PARTITION p2 VALUES LESS THAN (1980), PARTITION p3 VALUES LESS THAN (1990), -- MAXVALUE 确保分区取遍 PARTITION p4 VALUES LESS THAN MAXVALUE );如果希望按时间戳范围,可以用类似 UNIX_TIMESTAMP('2008-01-01 00:00:00') 的方式转换成整型,然后使用 UNIX_TIMESTAMP(<col>) 做 range partitioning;

其中,RANGE partitioning 如果按 Column 分区(就是加上 COLUMNS),不仅可以不用整型,而且还允许多列分区:

xxxxxxxxxxCREATE TABLE rcx ( a INT, b INT, c CHAR(3), d INT, renewal DATE) -- 按 Column 分区,可以不使用整型PARTITION BY RANGE COLUMNS(a,d,c) ( PARTITION p0 VALUES LESS THAN (5,10,'ggg'), PARTITION p1 VALUES LESS THAN (10,20,'mmm'), PARTITION p2 VALUES LESS THAN (15,30,'sss'), PARTITION p3 VALUES LESS THAN (MAXVALUE,MAXVALUE,MAXVALUE) );-- 例如可以不需要转成时间戳:PARTITION BY RANGE COLUMNS(renewal) ( PARTITION pWeek_1 VALUES LESS THAN('2010-02-09'), PARTITION pWeek_2 VALUES LESS THAN('2010-02-15'), PARTITION pWeek_3 VALUES LESS THAN('2010-02-22'), PARTITION pWeek_4 VALUES LESS THAN('2010-03-01') );其中建议确定数据是线序的再这么建立,不然会对 MySQL 存储引擎的记录比较造成疑惑。

但如果按照 Column 分区,只接受 column 名称,而不能是表达式。好处就是能不用整型、接受多列。

7.1.2 LISTING Partitioning

LIST partitioning: 与按范围分区类似,只是分区的选择基于与一组离散值之一相匹配的列。

考虑实际应用,对下面的雇员表:

xxxxxxxxxxCREATE TABLE employees ( id INT NOT NULL, fname VARCHAR(30), lname VARCHAR(30), hired DATE NOT NULL DEFAULT '1970-01-01', separated DATE NOT NULL DEFAULT '9999-12-31', job_code INT, store_id INT );按雇员的不同地区分区:

xxxxxxxxxx-- 加上PARTITION BY LIST(store_id) ( PARTITION pNorth VALUES IN (3,5,6,9,17), PARTITION pEast VALUES IN (1,2,10,11,19,20), PARTITION pWest VALUES IN (4,12,13,14,18), PARTITION pCentral VALUES IN (7,8,15,16));问题是,如果插入的一些记录不属于这些定义的列表内,那么就无法插入(报错)。如果:

不想报错:插入时加入

IGNORE:INSERT IGNORE INTO h2 VALUES (2, 5), (6, 10), (7, 5), (3, 1), (1, 9);想其他值全部归到一个单独分区内:不行。there is no “catch-all” such as MAXVALUE;

因此,我们建议对某个固定的枚举量的列来这么做 LIST partitioning;

同样,LIST 分区也可以用 COLUMNS 来不使用整型。

其中,RANGE 和 LIST 分区,如果指定 COLUMNS(表示按 Column 分),则都支持不按非整型数据(如日期、字符串)类型来分区。例外如下:

但是

DECIMAL / FLOAT之类的浮点数类型;与

DATE / DATETIME相关但不是的类型;TEXT / BLOB不支持(CHAR, VARCHAR, BINARY, VARBINARY都支持);

7.1.3 HASH Paritioning

HASH partitioning: 使用这种类型的分区时,分区的选择基于用户定义的表达式(某种方式计算要插入到表中的行中的列值)返回的值。

用户可以指定在 MySQL 中产生非负整数的所有非负整数表达式来作为 hash 函数。

举例:

xxxxxxxxxxCREATE TABLE employees ( id INT NOT NULL, fname VARCHAR(30), lname VARCHAR(30), hired DATE NOT NULL DEFAULT '1970-01-01', separated DATE NOT NULL DEFAULT '9999-12-31', job_code INT, store_id INT ) PARTITION BY HASH(store_id) PARTITIONS 4;但需要考虑数据散列均衡,例如下面的例子:

xxxxxxxxxxCREATE TABLE employees ( id INT NOT NULL, fname VARCHAR(30), lname VARCHAR(30), hired DATE NOT NULL DEFAULT '1970-01-01’, separated DATE NOT NULL DEFAULT '9999-12-31’, job_code INT, store_id INT ) PARTITION BY HASH(YEAR(hired)) PARTITIONS 4;这比较奇怪:按插入年份 hash,可能全年的雇员全部被放到一个分区中,短时间内没有很好的散列效果;

但是这么做的意图大多是为了加快查找,那么为何不将 YEAR 和 MONTH 一起 hash 呢?所以这种写法比较少。

在这种分区方法中,还支持另一种算法:Linear Hash。

它和普通散列的区别是,普通散列使用的只是散列函数值的模数,而 linear hash 采用 linear powers-of-two algorithm(线性二幂次算法);

优势是分布地更均匀(?)

算法如下:

xxxxxxxxxxprocedure power_of_two()// Find the next power of 2 greater than num;V := POWER(2, CEILING(LOG(2, num)));N := F(column_list) & (V - 1);while N |= num: V <- V >> 1; # V /= 2 N <- N & (V - 1);使用如下:

xxxxxxxxxxCREATE TABLE employees ( id INT NOT NULL, fname VARCHAR(30), lname VARCHAR(30), hired DATE NOT NULL DEFAULT '1970-01-01’, separated DATE NOT NULL DEFAULT '9999-12-31’, job_code INT, store_id INT )-- 这里加上 LINEAR 表示使用 linear hashPARTITION BY LINEAR HASH(YEAR(hired)) PARTITIONS 4;7.1.4 KEY Partitioning

KEY partitioning: 这种类型的分区与 HASH 分区类似,只是只提供一个或多个要评估的列,MySQL 服务器提供自己的散列函数。

这些列可以包含整数以外的值(就像 RANGE 和 LIST 的

COLUMNS修饰一样),因为无论列的数据类型如何,MySQL 提供的散列函数都能保证得到整数结果。

注意,KEY() 可以为空!MySQL 一般会默认主键。

举例:

xxxxxxxxxxCREATE TABLE members ( firstname VARCHAR(25) NOT NULL, lastname VARCHAR(25) NOT NULL, username VARCHAR(16) NOT NULL, email VARCHAR(35), joined DATE NOT NULL )PARTITION BY KEY(joined) PARTITIONS 6;其实本质上还是 hash partitioning,只不过这个 hash 函数交给 MySQL 实现。

同样可以用 LINEAR KEY 来指定 “线性的”(分布更均匀,但计算量更大);

7.2 Subpartitioning

可以按照不同维度来切分表。

xxxxxxxxxxCREATE TABLE ts (id INT, purchased DATE) -- 先按年份 用范围分区PARTITION BY RANGE( YEAR(purchased) ) -- 在上面分区的基础上,分区内继续按天用 hash 分区-- 共 3x2 = 6 个分区SUBPARTITION BY HASH( TO_DAYS(purchased) ) ( PARTITION p0 VALUES LESS THAN (1990) ( SUBPARTITION s0, SUBPARTITION s1 ), PARTITION p1 VALUES LESS THAN (2000) ( SUBPARTITION s2, SUBPARTITION s3 ), PARTITION p2 VALUES LESS THAN MAXVALUE ( SUBPARTITION s4, SUBPARTITION s5 ) );如果不需要子分区名字,也可以不指定:

xxxxxxxxxxCREATE TABLE ts (id INT, purchased DATE) PARTITION BY RANGE( YEAR(purchased) ) SUBPARTITION BY HASH( TO_DAYS(purchased) ) SUBPARTITIONS 2 ( PARTITION p0 VALUES LESS THAN (1990), PARTITION p1 VALUES LESS THAN (2000), PARTITION p2 VALUES LESS THAN MAXVALUE );7.3 How About NULL in Partitions?

如果分区后插入的依据列的值是 NULL 会出现什么?

我们知道,NULL 数据列在任意判断语句中都会返回 TRUE,因此:

以 RANGE partitioning 为例,依据列为

NULL的一定会被放入当前 RANGE 的最低一档(因为判断一定返回TRUE);因此 如果插入

NULL的数据比较多,那么可能造成分区效果不好。以 LIST partitioning 为例,需要显式指定

NULL在哪个列表内,否则会报错(这里能区分出来!);以 HASH / KEY partitioning 为例,它们会把

NULL和0看成等价的东西,也就是(0, 'sth')和(NULL, 'others')一定在一个分区(如果以第一个列为 HASH/KEY 分区依据);

7.4 Partitioning Management

在后期修改表的分区时,会比较耗时,因为不同分区确实可能在不同物理位置,需要物理上的转移过程。

完全修改、追加、覆盖。

re-organize 整个表的分区和完全修改一样非常耗时;

注意,对于 LIST partitioning 而言,ADD 追加的新 list 中,如果有重复元素则会报错。需要 REORGANIZE 来覆盖前面的定义。

而且需要考虑到分区(尤其是 RANGE/LIST)的实际含义(例如时间代表了特定历史阶段),那么应该按照这些含义来分,使得一次查询尽可能落在一个分区内,方便 Query Plan 进行优化。

7.5 分区与表 的交换

允许一个表的某一分区在另一张表中维护。

如果有些时候,需要一个表和另一个表中的某个分区的内容交换,可以使用:

xxxxxxxxxxALTER TABLE pt EXCHANGE PARTITION p WITH TABLE nt;但是要注意一些显然的条件:

被交换的表自己不能分区;

被交换的表不能是临时表;

被交换的表和被交换分区必须完全相等;

被交换的表和被交换分区必须有相同的 row format(

INFORMATION_SCHEMA.INNODB_TABLES查询);被交换的表:不能有外键关联、不能有不符合交换入的分区条件;

注意,如果交换的表中有些记录不符合交换入的分区条件,则会报错。如果仍然希望继续插入,则在上面的语句中追加 WITHOUT VALIDATION;

Chapter 8. NoSQL

8.1 Why we need it?

为什么需要 Not-Only SQL?

数据量太大;

MySQL 不是可以分区吗?

Partition 不能解决问题。超过 10 M 条数据后性能不佳;

如果拆表,不容易保存数据一致性;

非结构化数据难以存放在 SQL 中。尤其是基于文档(document)、基于图(graph)、基于文本的;

关系型数据库在大量数据存储和处理过程中存在劣势:

支持的数据大小级别 GB;

通常难以应对没有预先定义的 schema 的情况;

难以 scaling,scaling 不是线性的;

虽然 NoSQL 能保证大量非结构化数据的存储性能,但规范上来说不需要保证 ACID 事务特性(可能仅有最终一致性等 Weak Consistency Model)。

8.2 MongoDB

一个基于文档的(document-based)数据库。有几个概念:

document:文档,通常以非结构化的文本或二进制信息组成,相当于一条数据记录;

collection:一组文档的集合,相当于关系型数据库的表,但是是 schema-free 的形式;

在同一个 collection 中多个 document 有默认拥有特殊键

_id在 collection 中的唯一属性;因为是 schema-free 的,所以没有 “主键” 的说法。

database:由多个 collections 组成的数据结构。每个 database 可以有独立的权限、可以存放在不同物理介质上;

8.2.1 Definitions

Document

一个 simple document 可以包括一个或多个键值对(类似 JSON),但不以 MySQL 中的 Blob 相同方式存储。

注意 MongoDB 的 type-sensitive 和 case-sensitive 的;

Key 在同一个 document 中不允许重复;

Key 中不能包括

'\0';.、(space) 开头的字符只能用在一些特殊属性中;_开头的字符表示应该是保留字;

注意,我们也不能只用一个 collection,例如:

xxxxxxxxxx{ "name" : "John Doe", "address" : { "street" : "123 Park Street", "city" : "Anytown", "state" : "NY" }, "order": [ { "orderId": 1, "orderItems": [{}] } ]}有几个问题:

这是不易于维护的,尤其是在一个 collection 中出现很多 nested document;

性能原因:通常情况下,解析一个 nested list of types 比解析 a list of collections 要慢;

管理同类数据更能利用 data locality,并且更容易创建索引;

Collection

命名规范:

collection name 不能为空;

不能用以

system开头的名称;用户创建的 collections 不能使用 reserved characters;

使用 sub-collections:

使用

.来在组织层面 subcollections,例如blog.authors和blog.posts,它们和blog没有关系,甚至blog可以不存在;

Database

有个实践经验和建议:建议将单个应用的数据都放在一个 database 中;

有几个保留数据库:

admin: This is the “root” database, in terms of authentication.local: This database will never be replicated and can be used to store any collections that should be local to a single server.config: When Mongo is being used in a sharded setup, the config database is used internally to store information about the shards.

8.2.2 Indexing

MongoDB 这类 NoSQL 如何建立索引?

Normal Index:一般索引可以直接用 CLI

<collection>.createIndex(boolFilterObject)来建立;注意

boolFilterObject用 0/1 标识是否索引,-1/1 表示是反序还是顺序;这样查询时同样使用 leftmost 来索引。注意设置索引时的考量(类似关系型数据库);

但是没有 static schema 怎么办?不相关的记录不加入索引就行!不需要报错。

Geospatial Indexing:地理索引(使用指定的 “坐标” 索引),会利用类似 R-Tree 的数据结构来计算不同 document 的指定属性中的点的具体情况(如距离)来索引;

能加速查找离指定数据最近的 N 个 document;

默认欧式坐标(flat plane);

8.2.3 Sharding

Reasons

考虑一种情况,当 MongoDB 的数据量很大的时候,我们需要将数据切片,并 scale out 到不同集群上去。

除此以外,还有哪些情况需要切片?

单机磁盘空间不够用:当前机器的存储空间即将耗尽;

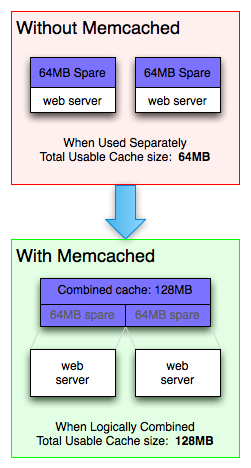

I/O 不够用:当前用户数很大,我们需要将写操作分散到多台物理节点上以加速(上锁还是需要上锁的,只不过多个机器 Disk I/O 够用一些);

Memory 不够用:想把更多数据放在 memory 中;

这个将数据切片(把一个 Collection 中的 Documents 拆成多个 Chunks 负载在不同物理节点上)的动作在 MongoDB 中被称为 “Sharding”;

Shard & Chunks

MongoDB Sharding 非常类似 MySQL 的 Partition 机制。但二者有区别:

MySQL Partition 针对表进行,需要手动指定分区;

MongoDB Sharding 针对 Collection 进行,不受用户指定自动进行,因此又称 Autosharding;

它们二者的 Chuck/Partition 具体存在集群的哪里,都对用户透明。

例如在 MongoDB 中,多个 chunks 的查找工作是由 router 决定的,它会记住每个 chunk 存在集群的位置。

除了 router,MongoDB 还会为每个 shard server 分配合理数量的 chunks,确保每两个 shard server 存放 chunks 数量相差不超过 2(可以配置、可以关闭)。

为什么有些时候需要关闭?考虑数据的热点程度不一样,有些热点数据可能占用大小较小,但访问次数远高于其他数据,因此为了 CPU / Memory 负载均衡,这种情况下如果只是用 chunk 数量来决定分配显然是不合适的;

Shard Mechanism 如下:

主要关注 MongoDB 何时 split、sharding chunk 存放的位置,等等。

实际上当 MongoDB 插入一个数据后,生成的 _id 并不是自增键,而是类似 Java GUID 一样的随机标识数。

8.3 Neo4J

8.3.1 Definitions

一种图数据库,专门用来存储图(graph)数据结构。在这种需求下,使用传统的关系型数据库、基于文档的 NoSQL(例如 MongoDB)可能不再胜任。

例如,一个存在用户、订单、订单项、产品信息 4 个表的关系型数据库,如果想要找用户买过的产品详细信息 / 产品被哪些用户买过(查看实体 User 和实体 Product 间的相互关系),则至少需要进行 3 次 JOIN 操作。如果这种查询比较常见的话,性能问题就无法被忽视了。

再比如,如果想要存放两个人的 follow 关系。将用户信息、follow 信息放在两个表中,follow 信息记录 persion ID 和 friend ID(为了方便查找存在一倍数据冗余),

那么查找某人的好友,至少需要 2 次 JOIN 操作(先查用户的所有 Friend IDs,然后找这些 Friend IDs 对应的用户);

查找谁的好友是某人,同样至少需要 2 次 JOIN 操作(先查 follow 表中的所有 Friend ID 是指定用户的 Person IDs,再找这些 IDs 对应的用户);

查找好友的好友?那至少需要 3 次 JOIN 操作!找 N 轮好友的好友就要 N+1 次 JOIN 操作,这在频繁查询的场景下是不可接受的(JOIN 笛卡尔积再操作,两个表很大时

不可接受); 因此我们说 “关系型数据库中缺少表示相互关系的手段”。

那我们之前的基于文档的 NoSQL (MongoDB)能否解决问题?

我们以第一个例子为例,在 MongoDB 中可以有两种设计方法:一种,用户和订单、订单项全部嵌套在一起,放在一个 Document 中;另外一种用户和订单分开。这时如果要找用户购买的产品信息,就不需要 JOIN 了!

看起来这两种方法都成功解决了 JOIN 问题?那我如果想看产品被哪些用户买过呢?问题就又出现了!这次问题比关系型数据库还要难以解决(扫描全部用户的)。

那第二个例子呢?我们将朋友作为 ID 数组存储,会遇到相似的问题。找朋友关系变快了,但朋友的朋友还是很慢。

我们认识到,如果业务逻辑需要频繁使用实体间的相互关系时,无论是关系型数据库,还是基于文档的 NoSQL 都没法高效地解决问题。

因此人们提出了图数据库。

图数据结构主要存放一组结点和边(vertices & edges):

一个结点类就是面向对象设计中的 实体类(entity),它可以存放多种属性,结点可以基于这个类在图上存在多个实例。

每个结点间可以有各种有向边的关系,每条边可以用 Label 标识。

这种标识方式被称为 “Labeled Property Graph”;

图数据库主要是对事务操作进行了优化,能保证事务完整性(fully ACID compliant)。

它的架构一般可以分为 underlying storage 和 processing engine 两个部分。其中处理引擎类似 MySQL 的 QueryPlan,underlying storage 则是指令执行系统和文件管理系统;

8.3.2 Data Model

以 Neo4J 为例,一个图的表示、查询、修改方法都可以使用 Cypher 语言(内置)描述。

8.3.3 Storage Mechanism

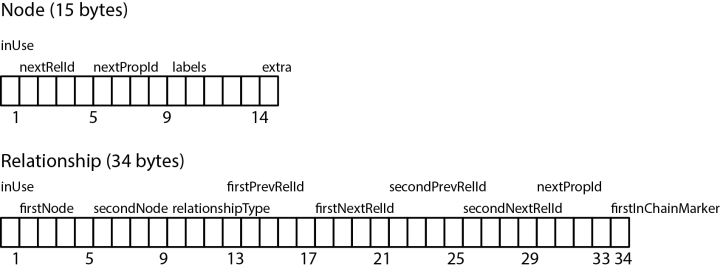

使用类似邻接表的方式存储:

8.4 Log-Structured Database

注意到有些情况下,关系型数据库、基于文档或者图的数据库都没法高效解决 “数据热点和创建时间相关” 的数据的查询操作。例如,如果 MySQL 想要在大量数据情况下查找最近几次插入的数据,这个时候由于表中没有与创建时间相关的信息,因此比较麻烦(按时间分区?如果有其他分区需要呢,例如按用户名?创建子分区得不偿失)。

这个时候就需要日志结构型数据库(准确地说,是日志型键值存储系统)。

例如 LSM Tree(适用于写多读少场景,不再赘述)。

优点:

大幅度提高插入(修改、删除)性能;

内存写相当快,并且可以异步刷盘;

写放大率降低;

访问新数据更快,适合时序、实时存储;

数据热度分布和 level 相关;

缺点:

牺牲了读性能(一次可能访问多个层);

可能出现写性能尖峰(Compaction),并且存在写阻塞;

即便有 Bloom Filter,对非热点数据的查找可能会逐层叠加造成读性能问题;

适用场景:

热点键值数据的快速存储。存放在单机的文件系统中,不考虑分布式;

如果是很大量的数据(到了需要分布式的场景),因为存在读性能/写性能尖峰,对这种旧数据应该交给 MySQL / MongoDB 等数据库。

日志结构数据库中的读放大和写放大

读放大:(如果不使用 Bloom Filter)访问不存在日志结构数据库中的数据,或者 访问一个热度不高、时间比较久的数据时,都会导致 日志结构数据库找穿内存,向下访问多层 SSTable,触发多次 Disk I/O,显著降低查找性能;

写放大:“写放大” 指每次写都有可能触发日志型数据库的 compaction 机制,而 compaction 时可能会出现级联 compaction、merge 以及日志的垃圾回收,这时会导致写阻塞,出现写时延尖峰;

补充:“空间放大” 指在日志型数据库不做 compaction、不做 SSTable merge 以及不做 Append-Only Log 的 garbage collection 的前提下,由于 Append-Only 的性质会导致存储数据的日志文件不断增大,最终存储代价远远超过原数据本身;

8.5 Vector Database

8.5.1 Basic Concepts

Embeddings:对信息特征的数据形式的描述。例如一个 RGB 3 通道图片 224 x 224 x 3 数组被 flatten 后转为一个一维数组,这个一维数据可以是这个图片的 embedding;

如果是文本信息,我们可以有几种方法来 embedding:

one hot 编码:所有可能出现的单词各作为一个维度(表示 1w 个单词,向量就 1w 个维度)。好处是正交(单词间独立、没有相似性),坏处是稀疏、占用空间;

特征描述:使用不同特征作为维度(基向量),描述不同词汇;

这些可以被 embedding 的信息统称为 Content;

然后实际使用的方式如下:

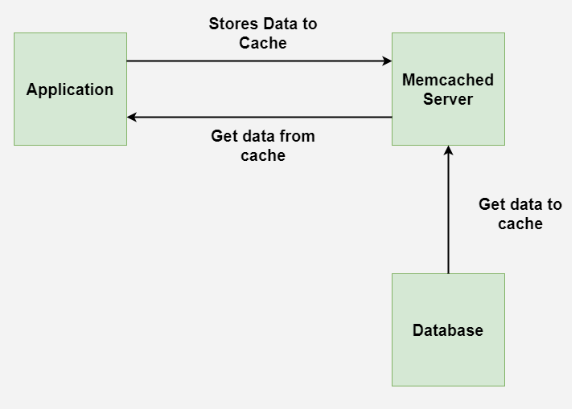

其中,从 Content 中抽取 embeddings 的过程由 embedding model 完成(它可以是自己预训练出的,也可以是大语言模型等等)。

输出的向量数据再交给向量数据库存储和查找。

注意几个点:

Vector Database 通常是使用 Approximate Nearest Neighbor (ANN) search,在找近似的结果,而不是精确匹配;

Vector Database 在插入数据时就需要建立索引方便查找;

最终我们会发现,创建索引后,向量数据库实际上只需要索引了(一般不需要原向量进行比较)!

8.5.2 ANN Search Algorithms

在维度不匹配时使用随机矩阵进行 random projection;

向量量化:

可能原始向量的维度较高,在资源缺乏或者其他场景下应用价值不高,因此我们需要进行量化:

将原始向量切分为若干块,每一小段可以做聚类处理(例如

123 213 132可以划分到同一个 group 中);一个 group 对应一个 code,这样向量的复杂度就会下降,虽然精度也会下降,但客观上提升了向量处理的性能;

局部相似性 hashing(Locality-sensitive hashing):

HNSW(Hierarchical Navigable Small World):

8.5.3 Similarity Measurement

余弦相似度、欧式距离、曼哈顿距离、点积……

余弦相似度:度量向量空间中两个向量之间夹角的余弦值,使用向量点积和夹角余弦的关系计算。

它的范围在 -1 到 1 之间,其中 1 代表完全相同的向量,0 代表正交向量,-1 代表完全不同的向量。

欧氏距离:测量向量空间中两个向量之间的直线距离。通常可以用向量的二范式计算:

可以表征空间中两个向量之间的“距离”。它的范围从 0 到无穷大,其中 0 代表相同的矢量,数值越大代表矢量越不相同。

曼哈顿距离:相当于向量的无穷范数,

8.6 Timeseries Database

数据存储根据时间作出优化。

数据会源源不断地来,因此每个数据都需要有过期时间;

格式非常简单(不存在表和表间的关联,大多数是监控数据),不仅可以存 raw,还可以存 delta;

所有数据都带时间戳,可以带前缀(相同的 timestamp

_time)存储,减小存储开销;

InfluxDB 的概念:

一个 Point 就是一个包含 series key、field value 和一个 timestamp 的结构;

时序键(series key):一组时序就是共享 measurement(

_measurement), tag set, 和 field key 的集合。

带有

_开头的,都是系统保留的字段,也就是一定会有的一个列,反之都是用户自定义的字段。

_time:时间戳,数据对应的时间,因为可能同一个时间会接收到很多数据,所以很可能同一个时 间接收到很多数据,所以时间戳不能唯一的标识。时间戳非常准确,精确到纳秒级别。

_measurement:起一个名字,一个统称,这个表格在干啥。census 就是调查种群数量。这里我们 发现它是共享的,所以存储的时候会优化,只存储一次。

_field:存储的是 key,比如下表里面存储的就是某个物种的名字;和_value构成键值对。Field 可以 作为筛选的依据,得到一个 Field Set。

_value:存储的是 value,类型可以是 strings, floats, integers, or booleans,之所以不能是别的,是 因为如果是复杂的数据类型转换会耽误时间,效率降低,所以就只能存这些基础的数据类型。Series:measurement, tag set, 和field key都相同的点集合。

Point:一个数据点,带有时间戳的数据点。E.g.

2019-08-18T00:00:00Z census ants 30 portland mullenBucket:存储桶,归属于一个组织,存储相对应的数据点集合。

Organization:组织,里面有一组用户,里面有若干个bucket。

注意到 InfluxDB 的一些注意事项:

fields 不会作为索引,因为它很容易变化。因此如果以这列做索引,则会出现全表扫描的问题;

tags 会作为索引;

和 LSM Tree 类似,支持 Append-Only,严格限制 update 和 delete;

没有 ID 的概念,因为很少有拿单条记录的情况,通常是取一个数据集;

不存储除了 timestamp 外完全相同的数据(只存变化),因为信息熵的冗余问题;

整个数据库只保证最终一致性(可能存在 missing update 的问题);

Quiz:如何判断将数据存为 Field 还是 Tag?

在 InfluxDB 中,决定将数据存储为

field还是tag主要取决于数据的查询模式和使用场景。对于服务器的 CPU 占用率和内存占用率,应该存储为field,原因如下:

CPU 和内存占用率是数值数据

field用于存储数值类型的数据(如浮动点数或整数),并且这些数据通常是变化的;CPU 占用率和内存占用率通常会随着时间变化,具有浮动的特性,因此它们应当存储在

field中,方便进行聚合(如平均值、最大值等)、筛选和排序等操作。

Tag 的作用

tag主要用于存储具有高基数(不同值的数量非常多)的分类数据,通常是维度字段,作为索引使用。

CPU 占用率和内存占用率不是具有高基数的分类数据,而是时间序列的连续数值,因此它们不适合作为

tag存储。tag存储的字段通常用于区分不同的数据系列,比如服务器的名称、数据中心的 ID 或操作系统类型等。

查询性能

tag字段可以用于快速的查询过滤,因为它们是索引的。而field不会被索引,查询时需要扫描所有的field数据。存储数值数据(如 CPU 和内存占用率)在

field中,而不是在tag中,有助于避免因tag的高基数带来的查询性能问题。结论:服务器的 CPU 占用率和内存占用率应该存储为

field,因为它们是数值数据,且不会用作分类维度进行查询过滤。而tag应用于具有分类属性的数据,能够高效地进行维度查询。

InfluxDB 存储引擎一般要写入几步:

Write Ahead Log (WAL);

Cache;

Time-Structed Merge Tree (TSM);

Time Series Index (TSI);

InfluxDB 中的索引比关系型数据的索引(指定列、指定升降序、指定索引数据结构 等等)简单多了,只需要拿着 series key 索引即可。

另外,InfluxDB 有一套自己的文件系统管理方式。TSM 和 WAL 需要放到两个地方,保证异地容灾。

还有,InfluxDB 和 MongoDB 一样,使用 Shards(分裂方法、管理方法都类似)来管理大量文件。不过 InfluxDB 会根据过期时间范围构建 shard group;

shard group 可以 precreation、compaction 过期删除等动作;

InfluxDB compacts shards at regular intervals to compress time series data and optimize disk usage.

InfluxDB uses the following four compaction levels:

Level 1 (L1): InfluxDB flushes all newly written data held in an in-memory cache to disk.

Level 2 (L2): InfluxDB compacts up to eight L1-compacted files into one or more L2 files by combining multiple blocks containing the same series into fewer blocks in one or more new files.

Level 3 (L3): InfluxDB iterates over L2-compacted file blocks (over a certain size) and combines multiple blocks containing the same series into one block in a new file.

Level 4 (L4): Full compaction—InfluxDB iterates over L3-compacted file blocks and combines multiple blocks containing the same series into one block in a new file.

Chapter 9. Concurrency Control

9.1 Thread in Java

9.1.1 Usage

默认读者已经在 ICS 中学习了很详细的关于 thread 和 process 的知识,并且学会在 C/C++ 中使用线程和进程。

我们本节的目的是在 Java 中使用线程。两种方法:

使用

RunnableInterface:重写

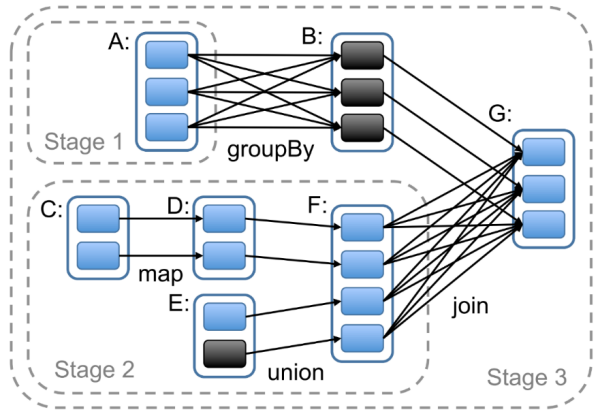

public void run()方法;将这个类的实例作为